博文

人工智能是否可以撰写科学论文?《自然》调查  精选

精选

|

人工智能是否可以撰写科学论文?《自然》调查显示研究人员观点分歧

对5000名研究人员的调查显示,人们对何时允许人工智能参与以及需要披露哪些信息存在不同看法。

插图:Acapulco Studio

人工智能(AI)革命正在多大程度上改变科学成果的传播过程?随着ChatGPT等生成式AI工具的迅速改进,学术界对使用它们撰写研究论文的态度也在演变。有迹象显示使用AI的论文数量正在迅速增加(D. Kobak等人,预印本发表于arXiv,https://doi.org/pkhp;2024),这引发了关于剽窃和其他伦理问题的讨论。

为了解研究人员对这一话题的看法,《自然》向全球约5000名学者提出了多种假设场景,以了解哪些AI使用方式被认为符合伦理规范。

参与《自然》的AI研究伦理测试:看看你的伦理观如何

调查结果显示,研究人员对AI的合理使用方式存在明显分歧。尽管学者们普遍认为使用AI聊天机器人辅助准备手稿是可以接受的,但实际使用AI进行此项工作的人相对较少——而且使用过的人往往表示未披露这一点。

过去的调查显示,研究人员还使用生成式AI工具辅助编程、激发研究灵感以及完成许多其他任务。在某些情况下,学术界已普遍认为这些应用是合适的(如生成AI图像则被认为不可接受)。《自然》的最新调查聚焦于论文撰写和审稿——这些领域的伦理规范尚不明确。

分歧的格局

《自然》的调查列出了一个虚构学者“Bloggs博士”未披露使用AI的若干场景,例如生成论文初稿、编辑自己的草稿、撰写特定章节以及翻译论文。其他场景包括使用AI撰写同行评审意见或为Bloggs博士正在评审的手稿提供建议(完整调查、数据和方法见补充信息,你也可以通过部分调查问题测试自己的观点)。

调查参与者被问及他们认为哪些做法是可接受的,以及他们是否在这些场景中使用过AI或愿意使用。他们未被告知期刊政策,因为调查旨在揭示研究人员的潜在观点,且采用匿名形式。

5229名受访者于3月通过以下方式联系:随机发送电子邮件给全球近期发表研究论文的作者、施普林格·自然作者和审稿人市场研究小组的部分参与者,或通过《自然》每日简报通讯邀请。由于不可避免的回应偏差,他们未必代表全体研究人员的观点,但涵盖全球各地——例如,在声明国家的受访者中,21%来自美国,10%来自印度,8%来自德国——并涉及不同职业阶段和研究领域(中国作者代表性不足,主要因为许多人未回复电子邮件邀请)。

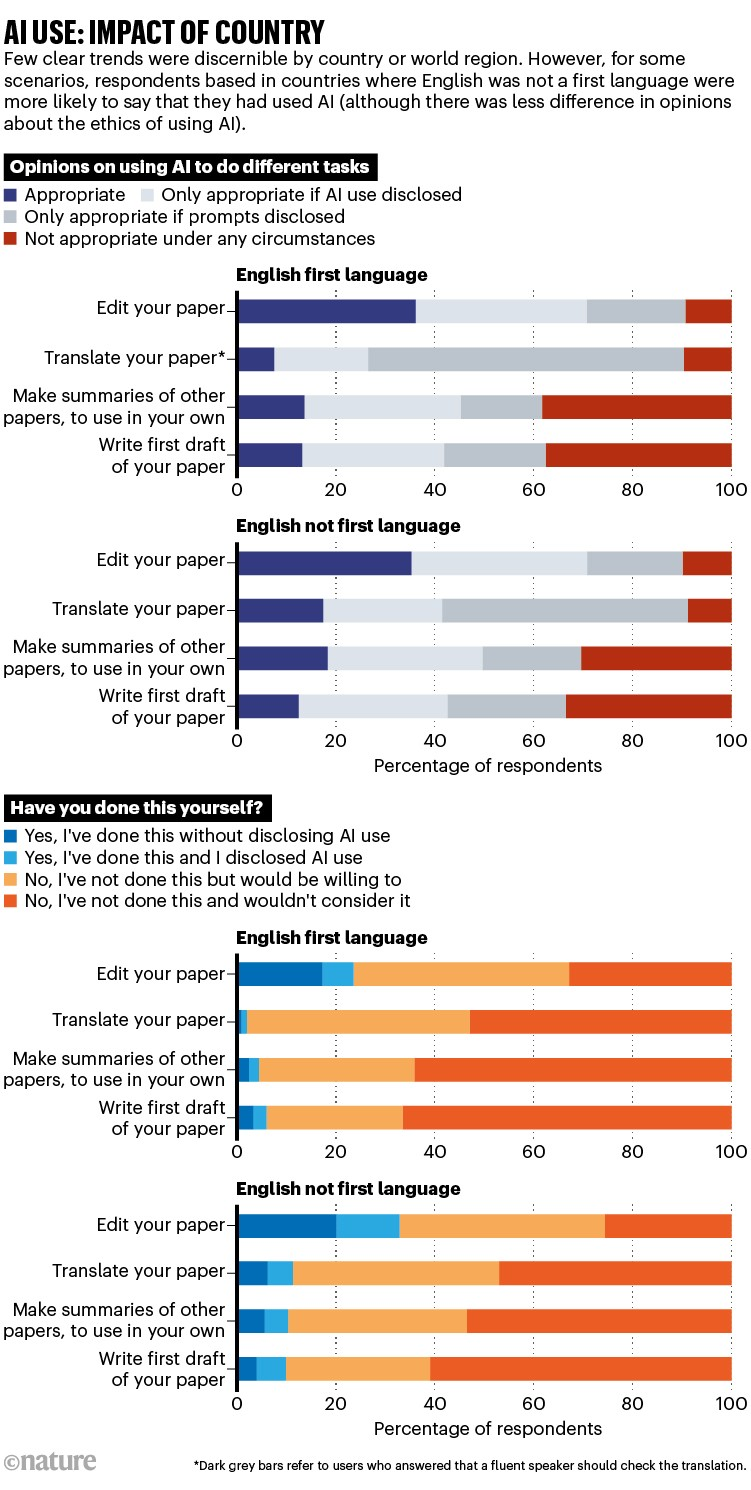

调查显示,当前学术界对AI使用的看法差异显著——有时甚至大相径庭。大多数受访者(超过90%)认为使用生成式AI编辑或翻译研究论文是可接受的,但在是否需要披露AI使用以及如何披露(例如通过简单声明或详细说明提供给AI工具的提示词)上存在分歧。

在使用AI生成文本方面(例如撰写论文的全部或部分内容),观点更为分化。总体而言,多数人(65%)认为这在伦理上是可接受的,但约三分之一的人表示反对。

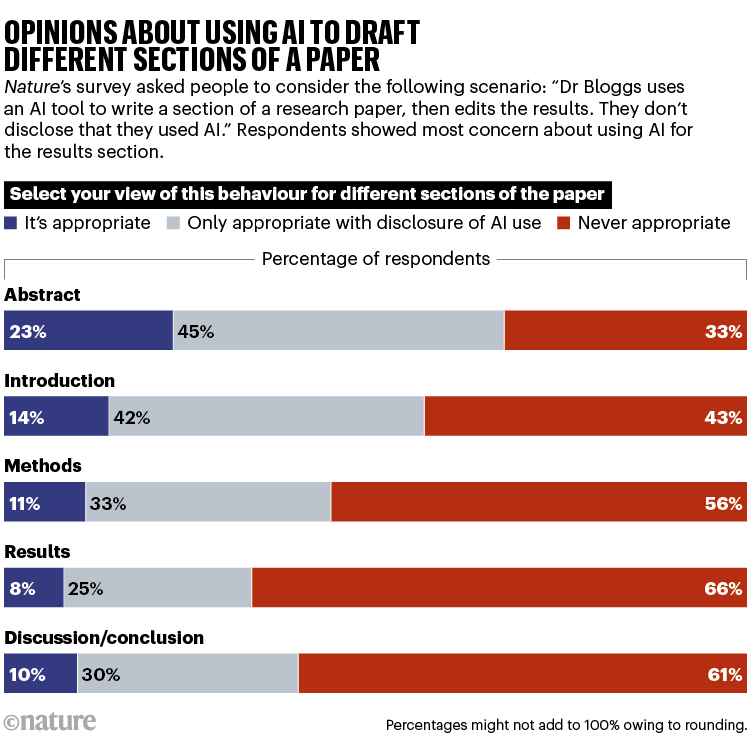

当被问及使用AI撰写论文特定章节时,多数研究人员认为撰写摘要可接受,但更多人反对用AI撰写其他章节。

肯塔基大学研究素养与传播讲师亚历克斯·格林(Alex Glynn)表示,尽管出版商普遍认为学术写作中实质性使用AI应予以声明,但《自然》的调查显示并非所有研究人员都持相同观点。“这种分歧是反映了对该问题的不熟悉,还是与出版界的原则性分歧?”

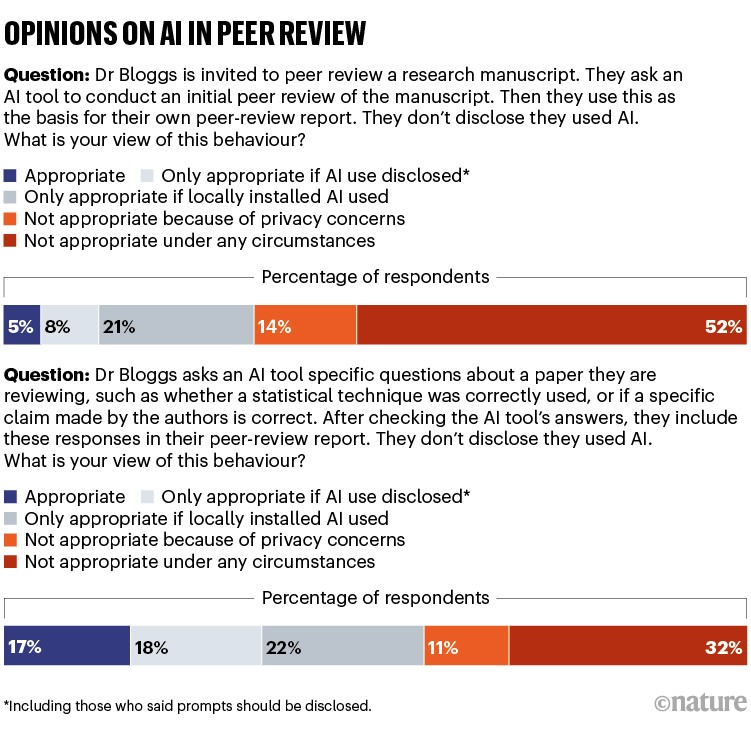

使用AI生成初始同行评审报告更不被看好——超过60%的受访者认为不合适(其中约四分之一提到隐私问题)。但多数人(57%)认为使用AI通过回答手稿相关问题辅助同行评审是可接受的。

“我很高兴看到人们认为使用AI撰写同行评审报告不可接受,但更令我惊讶的是,似乎有不少人认为AI辅助人类审稿人也不合适,”学术传播顾问克里斯·伦纳德(Chris Leonard)说,他在通讯《Scalene》中撰写关于AI和同行评审发展的文章(伦纳德同时担任印度孟买跨国公司Cactus Communications的产品解决方案总监)。“这种混合模式非常适合发现审稿人可能遗漏的问题。”

少数人使用AI

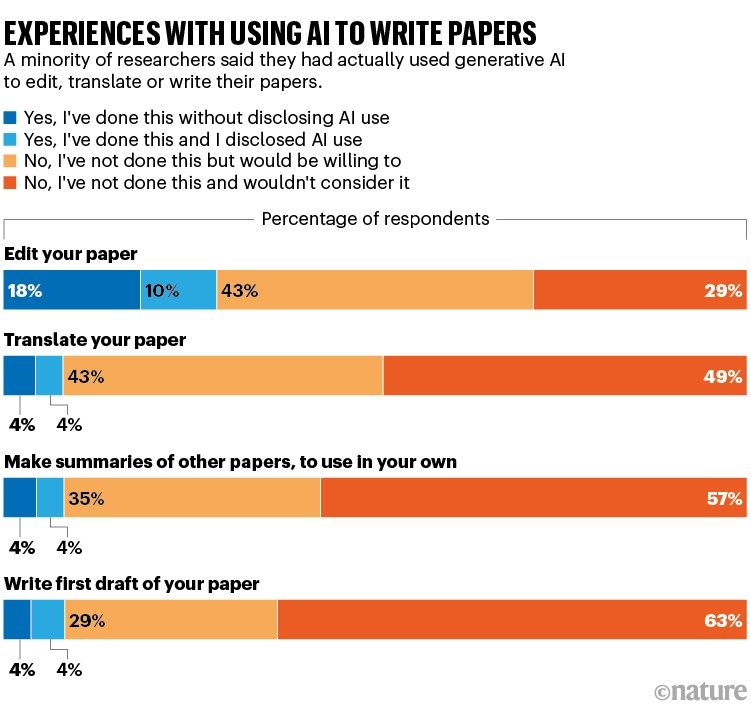

总体而言,很少有学者表示在《自然》提出的场景中实际使用过AI。最常见的场景是使用AI编辑研究论文,但只有约28%的人表示这样做过(然而,另有43%的人表示愿意尝试)。撰写初稿、为自己的论文制作其他文章的摘要、翻译论文和辅助同行评审的比例降至约8%。

仅4%的受访者表示使用过AI进行初步同行评审。

总体而言,约65%的受访者表示从未在任何场景中使用过AI,职业生涯早期的研究人员更可能至少在一种场景中使用过AI。但当受访者表示使用过AI时,他们往往未在当时披露这一点。

“这些结果印证了我们从研究人员那里听到的观点——人们对AI支持研究过程充满热情,但实际应用率较低,”跨国学术出版商威利(Wiley)高级副总裁乔希·贾勒特(Josh Jarrett)说,该公司也对研究人员的AI使用情况进行了调查。

观点两极分化

当有机会对自己的观点发表评论时,研究人员的意见差异极大。一方面,有人认为生成式AI工具的广泛应用使披露变得不必要。“AI即使尚未成为常态,也将像使用计算器一样成为常规,”曼谷朱拉隆功大学的生物医学研究人员艾萨万·佩奇洛里安(Aisawan Petchlorlian)说,“‘披露’将不再是一个重要问题。”

另一方面,有人表示AI使用永远不可接受。“我永远不会宽恕使用生成式AI撰写或评审论文,这是可悲的作弊和欺诈,”加拿大一位地球科学研究人员说。

其他人则更为矛盾。英国剑桥大学传染病研究者丹尼尔·伊根(Daniel Egan)表示,尽管AI节省时间且擅长综合多源复杂信息,但过度依赖会感觉像在欺骗自己。“使用AI让我们失去了通过参与这些有时繁琐的过程来学习的机会。”

受访者还提出了各种担忧,从剽窃、破坏出版和同行评审过程中的信任与责任等伦理问题,到对AI环境影响的担忧。

有人表示,尽管他们普遍认为使用这些工具可能符合伦理,但自身经验表明AI往往产生劣质结果——虚假引用、不准确陈述,以及如一人所述的“表述精美但内容无意义的废话”。受访者还指出,AI回应的质量可能因使用的具体工具而异。

也有一些积极观点:许多受访者指出,AI可以帮助英语非母语的学者公平竞争。

还有人解释了为何支持某些用途而反对其他用途。“我使用AI将西班牙语自译为英语,反之亦然,并对文本进行大量编辑,但我永远不会用AI从头生成内容,因为我享受写作、编辑和评审的过程,”一位西班牙人文研究人员说,“而且我永远不会用AI评审,因为想到被AI评审我会感到恐惧。”

职业阶段与地域差异

或许令人惊讶的是,学者的观点通常不会因地理位置、研究领域或职业阶段而有太大差异。然而,正如预期,受访者自我报告的使用AI撰写或评审论文的经验与对相关场景的正面看法密切相关。

在AI最常见的用途——编辑论文方面,职业阶段确实产生了影响。年轻研究人员更可能认为这种做法可接受,也更可能表示曾这样做过。

英语非母语国家的受访者通常比英语国家的受访者更可能在调查场景中使用AI,但他们对AI使用伦理的基本看法似乎差异不大。

相关调查

不同研究人员和出版商已对学术界的AI使用情况进行了调查,广泛探讨AI可能在科学过程中的应用方式。今年1月,加拿大渥太华医院研究所健康研究员杰里米·吴(Jeremy Ng)及其同事发表了一项对2000多名医学研究人员的调查,其中45%的受访者表示曾使用过AI聊天机器人(J. Y. Ng等人,《柳叶刀·数字健康》,2025年,第7卷,e94–e102页)。在这些人中,超过三分之二表示曾用于撰写或编辑手稿——这意味着总体而言,约31%的受访者曾为此目的使用AI,略高于《自然》的调查结果。

“我们的发现既显示了热情,也揭示了犹豫,”吴说,“它们进一步证实了一个观点:关于这些聊天机器人应如何、在何处或为何用于科学研究,尚未达成太多共识。”

今年2月,威利发布了一项对全球近5000名研究人员的AI使用调查(见go.nature.com/438yngu)。除其他发现外,该调查显示,研究人员认为AI的大多数用途(如撰写文档、提高同行评审的速度和便利性)将在未来几年被普遍接受。但不到一半的受访者表示实际在工作中使用过AI,40%的人表示用于翻译,38%用于论文校对或编辑。

“绝大多数人认为,未来两年AI将显著改变他们作为研究人员和作者的工作,”贾勒特说,“但阻碍他们的一大因素是关于AI安全和伦理使用的指南,以及使用AI时应如何适当披露。”

是否需要披露?

大多数研究出版商已制定AI指南,禁止使用AI创建、修改和操纵数据或结果(如图像)。他们通常还表示,AI工具不能列为作者,因为其无法对工作负责。但政策差异很大,尤其是在AI使用的披露方面。

许多出版商现在对AI的不同用途进行区分,通常分为两大类:改进文本(包括使用AI提升拼写、语法和可读性)与生成新内容。后者通常需要披露,而前者不需要。2023年,荷兰海牙的国际科学、技术和医学出版商协会(STM)建议,AI用于完善、纠正、编辑或格式化手稿等任务时无需披露,但超越这些基本任务的AI使用则需要披露。

一些期刊,如美国医学期刊《JAMA》,已实施严格的报告要求,要求使用AI的作者提供软件及其制造商的详细信息,以及使用方式的简要说明(这不适用于拼写和语法检查等简单任务)。作者还需确认对生成内容负责。

“目前,我认为这有点像报告利益冲突——最好倾向于披露,”伊利诺伊州芝加哥市《JAMA》执行常务编辑兼编辑运营副总裁安妮特·弗拉纳根(Annette Flanagin)说。

威利也要求作者分享使用AI的具体细节。一些期刊,如《科学》(美国科学促进会出版,华盛顿特区),要求作者提供提示词,作为解释如何在研究中使用AI的一部分。《自然》的伦敦出版商施普林格·自然表示,生成式AI的使用应“适当记录”,但AI辅助的文字编辑无需声明(《自然》新闻团队与出版商在编辑上独立)。

其他出版商则采取了不同方向:例如,英国布里斯托尔的IOP出版社最初要求作者声明AI使用,但后来取消了这一规定,转而在政策中仅鼓励作者透明使用,强调作者应对AI工具创建的任何内容负责。IOP出版社同行评审和研究诚信主管金·埃格leton今年4月告诉《自然》,这一改变是为了反映这些工具的普遍性。

出版商通常不太允许在同行评审中使用AI。阿姆斯特丹的爱思唯尔和美国科学促进会目前禁止审稿人使用生成式AI或AI辅助评审,而威利和施普林格·自然允许有限使用(需披露),并禁止将材料上传至聊天机器人网站,因为担心泄露机密信息。

《自然》调查的受访者也意识到这些隐私问题,有人表示,如果使用本地部署的AI辅助同行评审(不会在线泄露信息),则是可接受的。

需要明确性和透明度

由于AI使用和披露存在诸多不确定性,STM今年4月发布了一份报告草案,对稿件准备中的各种AI用途进行了分类(见go.nature.com/4tz8bkj)。

“我们希望出版商——以及更广泛的生态系统——采用这套术语,”STM子公司STM Solutions项目总监约里斯·范罗森(Joris van Rossum)说。

珀斯西澳大利亚大学的生物信息学家和计算机科学家迈克尔·怀斯(Michael Wise)表示,研究人员仍处于探索学术写作中AI使用伦理的早期阶段。怀斯也是出版伦理委员会(COPE)的受托人,该委员会是推荐学术出版最佳实践的咨询小组。

“需要强调的是,出版伦理的规范并未改变:在透明的前提下,准确报告所做的工作、原因以及从中可以得出的结论,”他说。

https://wap.sciencenet.cn/blog-41174-1485883.html

上一篇:饮用氢气纳米气泡水辐射防护作用研究【日本2025】

下一篇:牛磺酸能促进白血病发展,还能不能喝某牛?