精选

精选

AI科学家时代的标志:获得诺贝尔奖

人工智能研究已经获得诺贝尔奖,但AI自己下手独立开展科研工作,可否实现诺贝尔奖级别的研究。从逻辑上看,这只是时间问题。

人工智能会赢得自己的诺贝尔奖吗?一些人预测,一项值得获得诺贝尔奖的科学发现很快就会出现。其他研究人员质疑,自主人工智能科学家是否可能,甚至是否可取。

人工智能模型开始在科学领域崭露头角

过去两年间,人工智能(AI)模型已证明其具备数据分析、实验设计乃至提出全新假说的能力。这一发展速度让部分研究者确信,未来几十年内,AI有望与科学界最顶尖的人才一较高下。

2016年,生物学家、索尼人工智能公司(Sony AI)首席执行官北野宏明(Hiroaki Kitano)向研究者发起挑战:开发一套足够先进的AI系统,使其能实现足以斩获诺贝尔奖的科学发现。他将这一挑战命名为“诺贝尔图灵挑战”,并将其定位为AI在科学领域的重大攻关目标[1]。若某台机器能取得与人类顶级研究水平相当的发现,即可算作挑战成功。

目前的AI模型尚无法实现这一目标。但“诺贝尔图灵挑战”设想,到2050年,一套无需人类干预的AI系统将能整合假说生成、实验规划与数据分析能力,实现足以获诺贝尔奖的突破性发现。

而这一天或许无需等到2050年。英国剑桥大学化学工程研究者、该挑战的组织者之一罗斯·金(Ross King)认为,这样的“AI科学家”甚至可能更早跻身诺奖得主行列。“我几乎可以肯定,AI系统终将强大到足以赢得诺贝尔奖,”他表示,“问题只在于需要50年还是10年。”

然而,许多研究者认为,当前的AI系统是基于人类现有知识库训练而成,其核心功能是生成文字序列与观点,难以产生真正新颖的见解。要实现上述突破,可能需要彻底改变AI的研发方式及资金投入方向。“如果明天能有一项政府计划为基础研究投入10亿美元,我认为AI的发展速度会快得多。”美国南加利福尼亚大学(位于洛杉矶)的AI研究者约兰达·吉尔(Yolanda Gil)说道。另有研究者警告,将AI引入科研流程潜藏着不容忽视的风险[2]。

足以获诺奖的发现

诺贝尔奖设立的初衷,是表彰那些“为人类带来最大福祉”的人——这是诺贝尔奖创始人阿尔弗雷德·诺贝尔(Alfred Nobel)在遗嘱中写下的宗旨。对于科学类奖项,前诺贝尔化学委员会主席、化学家本特·诺登(Bengt Nordén)提出了三项评判标准:他认为,一项能获诺奖的发现必须具备实用性、深远影响力,并能为后续科学认知打开新的大门。

尽管目前诺贝尔奖的评选对象仅限在世个人、组织及机构,但AI此前已与诺贝尔委员会有过“交集”。2024年,诺贝尔物理学奖授予了为人工神经网络奠定基础的机器学习先驱;同年,诺贝尔化学奖的一半奖项表彰了AlphaFold背后的研发团队——AlphaFold是英国伦敦DeepMind公司开发的AI系统,可通过氨基酸序列预测蛋白质的三维结构。不过,这些奖项认可的是AI系统背后的科学突破,而非AI本身取得的发现。

根据“诺贝尔图灵挑战”的定义,若要让“AI科学家”拥有属于自己的发现,其研究过程必须“完全或高度自主”。吉尔指出,这意味着AI需要全程主导科研流程:确定待解答的问题、规划要开展的实验、选择需分析的数据。

德米斯·哈萨比斯(Demis Hassabis,左)与约翰·詹珀(John Jumper,中)因AI模型AlphaFold荣获诺贝尔奖。图片来源:Jonathan Nackstrand/法新社 via Getty Images)

德米斯·哈萨比斯(Demis Hassabis,左)与约翰·詹珀(John Jumper,中)因AI模型AlphaFold荣获诺贝尔奖。图片来源:Jonathan Nackstrand/法新社 via Getty Images)

吉尔表示,她已观察到AI工具在发现过程的几乎每一步都能为科学家提供协助,这“让该领域充满活力”。研究者已证实,AI可助力破译动物的“语言”、提出宇宙生命起源的假说、预测旋转恒星的碰撞时间,还能预报致命沙尘暴、优化未来量子计算机的组装流程。

AI也正开始独立开展实验。美国宾夕法尼亚州卡内基梅隆大学的化学家加布·戈麦斯(Gabe Gomes)及其团队设计了一套名为“Coscientist”的系统,该系统依托大型语言模型(LLM,即ChatGPT及同类系统的核心技术),利用自动化实验室设备规划并执行复杂的化学反应[3]。戈麦斯透露,尚未公开的Coscientist新版本还能以极高速度完成计算化学相关工作。

戈麦斯的一名学生曾抱怨,该软件需要半小时才能算出某个反应的过渡态。“而我读研究生时,解决这个问题花了整整一年。”戈麦斯说。

日本东京的Sakana AI公司正利用LLM尝试实现机器学习研究的自动化[4]。与此同时,谷歌及其他机构的研究者正探索让聊天机器人以团队协作的方式生成科学观点。

大多数使用AI的科学家会将其视为某种助手或合作者,通常分配特定任务。美国加利福尼亚州旧金山FutureHouse研究实验室的首席执行官萨姆·罗德里格斯(Sam Rodriques)表示,这是AI进军科学领域的“第一波浪潮”。该实验室于今年早些时候推出了一款专为化学任务设计的LLM。这类“推理模型”及其他类似模型通过对正确案例的训练,借助试错过程学习模仿逐步的逻辑思考。

现有模型作为协作工具颇具价值:它们能基于数据进行预测,加速原本耗时费力的计算工作。但在科研的至少某个阶段,它们往往仍需人类参与。

DeepSeek AI模型的核心机制在里程碑式论文中揭晓

罗德里格斯表示,AI进军科学的“第二波浪潮”将是:通过检索文献、分析数据,AI在提出和评估自身假说方面的能力会显著提升。美国加利福尼亚州斯坦福大学的生物医学数据科学家邹建(James Zou)已开始涉足这一领域。他与团队近期证实,基于LLM构建的系统可梳理生物数据,发现研究者遗漏的见解[5]。例如,给该系统输入一篇已发表的论文及相关的RNA序列数据集后,它发现新冠患者体内某些免疫细胞在死亡时更易肿胀——这一观点并未被论文作者提及。邹建表示,这表明“AI智能体已开始自主发现新事物”。

他还在协助组织本月晚些时候举办的一场名为“Agents4Science”的虚拟会议,他称其为首个“纯AI参与”的科学会议。所有论文均由AI智能体撰写并评审,人类研究者仅作为合作者参与。这场为期一天的会议还将包含(人类主持的)特邀报告及小组讨论,主题围绕AI生成式研究的未来展开。邹建希望通过这场会议,帮助研究者评估AI在开展和评审创新性研究方面的能力。

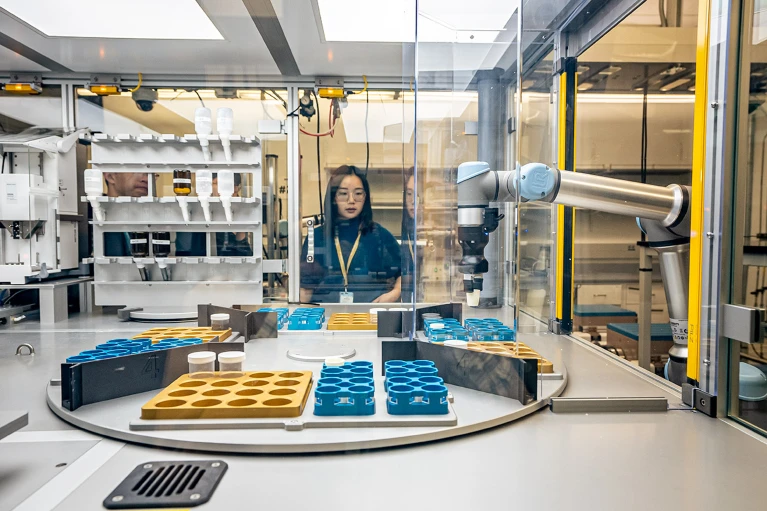

美国劳伦斯伯克利国家实验室的研究者曾 Yan(Yan Zeng)在A-Lab实验室查看研究起点。AI正协助该实验室研究者开发新材料。图片来源:Marilyn Sargent/伯克利实验室

邹建指出,这类尝试面临已知挑战,例如LLM常出现的“幻觉”(生成虚假信息)问题。但他认为,通过人类反馈,这些问题大多可得到缓解。

罗德里格斯表示,AI进军科学的“第三波浪潮”——也是FutureHouse的目标——是开发无需人类参与、能自主提出问题、设计并执行实验的模型。他认为这一目标势不可挡,并表示AI“最晚到2030年”就能实现足以获诺奖的发现。

他认为,无论是“AI科学家”还是人类科学家,最有可能取得突破性发现的领域是材料科学,或是帕金森病、阿尔茨海默病等疾病的治疗研究——因为这些领域存在重大未解决难题,且需求尚未得到满足。

思考“思考本身”

许多研究者对上述预测持谨慎态度,认为面临的障碍远大于此。美国华盛顿州西雅图艾伦人工智能研究所的道格·唐尼(Doug Downey)表示,他与团队发现,其开发的LLM智能体若尝试从头至尾完成一个研究项目,往往会以失败告终。在一项涉及57个AI智能体的研究中,团队发现:尽管这些智能体在约70%的情况下能完整完成特定的科学相关任务,但当它们需要独立生成观点、规划并执行实验、分析数据以形成完整报告时,成功率骤降至仅1%(详见链接:go.nature.com/4ntxs6q)。“端到端的自动化科学发现仍是一项艰巨挑战。”唐尼及其他作者在论文中写道。

唐尼表示,尽管AI在推动科学进步方面潜力巨大,但它并非没有局限性。“我认为,我们尚不清楚需要多长时间才能克服这些局限。”

即便如今的AI系统能在某一细分领域做出合理预测,它们也未必能掌握更宏观的底层原理。例如,近期一项研究发现,某AI模型虽能预测行星绕恒星的运行轨迹,却无法复现支配这些天体运动的基本物理定律[6]。它并非在学习科学原理,而更像是在模仿该原理产生的结果。另一项研究则显示,某AI工具即便学会了在纽约市导航,也无法绘制出准确的纽约市街道地图[7]。

美国亚利桑那州立大学(位于坦佩)的计算机科学家苏巴拉奥·坎布哈帕蒂(Subbarao Kambhampati)表示,这类缺陷表明,人类研究者的亲身体验对于破解基础科学原理至关重要。相比之下,AI系统只能通过输入的数据集间接“体验”世界。部分研究者正探索将AI与机器人结合,以让这些系统获得更多探索世界的实际经验。

坎布哈帕蒂认为,缺乏真实世界经验会使AI模型难以提出新颖、具创造性的问题,也无法为人类世界提供全新见解。“我完全支持‘AI能加速科学发展’的观点,”他说,“但声称‘不需要人类科学家,机器就能实现足以获诺奖的发现’,听起来不过是炒作而已。”

在吉尔看来,要开发出能实现诺奖级别发现的“AI科学家”,需投入更多精力研发具备更广泛能力的AI工具,包括“元推理”能力——即研究者需找到方法,让AI能够评估并调整自身的推理过程,也就是“思考自身的思考”。这一转变可能使AI模型能够权衡哪种实验能产生最佳结果,并根据新发现修正自身的科学理论。

长期以来,吉尔一直致力于能赋予AI此类能力的基础研究,但她表示,LLM已抢占了所有关注焦点。若这种情况持续,她认为诺奖级别的AI发现将变得遥不可及。“利用生成式AI技术确实能取得许多令人兴奋的成果,”吉尔说,“但还有很多其他领域值得关注。”

金也认同未来仍存在障碍。他表示,LLM对人类世界及自身贡献的意义缺乏理解:“它甚至不知道自己在做的是科学研究。”

“诺贝尔图灵挑战”相关会议的许多讨论,都聚焦于AI尚未实现的突破,以及如何实现这些突破。例如:“AI科学家”是否需要具备通用人工智能(即与人类同等的知识储备和适应能力)?“AI科学家”的行为会模仿人类科学家,还是会走出一条不同的发现路径?AI自动化发现会涉及哪些法律和伦理问题?为“AI科学家”设立奖项的资金又将从何而来?

要了解AI的能力极限,或许只能交给时间。“获取这些答案的唯一方法,就是像验证任何假说一样去测试它们。”吉尔说。

另有研究者质疑,科学界是否应该推动此类AI发现的实现。2024年,美国康涅狄格州耶鲁大学的人类学家莉萨·梅塞里(Lisa Messeri)与新泽西州普林斯顿大学的心理学家莫莉·克罗克特(Molly Crockett)在一篇文章中指出,在科学研究中过度依赖AI,已开始导致更多错误出现[2]。她们还指出,AI可能会排挤其他研究方法、降低创新能力,导致科学家“产出更多,理解更少”。

自动化发现可能会给科学——乃至科学家——带来严重的负面影响。梅塞里表示,AI正在承担原本属于青年科学家的任务,这可能导致他们永远无法掌握未来斩获诺奖所需的必要技能。“尽管这并非零和博弈,但考虑到当前科研及大学预算不断缩减,我们正处于一个需要审慎评估这种未来利弊的关键时期。”她说。

(原文载于《自然》杂志,第646卷,第276页)

转载本文请联系原作者获取授权,同时请注明本文来自孙学军科学网博客。

链接地址:https://wap.sciencenet.cn/blog-41174-1504911.html?mobile=1

收藏