博文

可信图神经网络的全面综述:隐私性、鲁棒性、公平性和可解释性

||

近年来,图神经网络(GNN)取得了飞速发展。由于其在图结构数据建模方面的强大能力,GNN 被广泛应用于各种领域,包括金融分析、交通预测和药物发现等高风险场景。尽管 GNN 在现实世界中具有造福人类的巨大潜力,但最近的研究表明,GNN 可能会泄露私人信息,容易受到对抗性攻击,会继承和放大训练数据中的社会偏见,并且缺乏可解释性,有可能对用户和社会造成无意伤害。例如,现有研究表明,攻击者可以通过对训练图进行不引人注意的扰动来欺骗 GNN,使其给出自己想要的结果。在社交网络上训练的 GNN 可能会在决策过程中嵌入歧视,从而强化不良的社会偏见。因此,为了防止 GNN 模型的危害,提高用户对 GNN 的信任度,关注 GNN 可信性各个方面的工作应运而生。来自美国宾夕法尼亚州立大学和密歇根州立大学的研究团队从隐私性、鲁棒性、公平性和可解释性等计算方面对 GNN 进行了全面考察。针对每个方面,团队给出了相关方法的分类,并制定了多类可信 GNN 的一般框架。团队还讨论了每个方面的未来研究方向以及这些方面之间的联系,以帮助实现可信性。相关成果已发表于《机器智能研究(英文)》2024年第6期中。

全文下载:

A Comprehensive Survey on Trustworthy Graph Neural Networks: Privacy, Robustness, Fairness, and Explainability

Enyan Dai, Tianxiang Zhao, Huaisheng Zhu, Junjie Xu, Zhimeng Guo, Hui Liu, Jiliang Tang, Suhang Wang

https://link.springer.com/article/10.1007/s11633-024-1510-8

https://www.mi-research.net/article/doi/10.1007/s11633-024-1510-8

全文导读

生物信息网络、交易网络和社交网络等图结构数据在现实世界中无处不在。受深度学习在独立且同分布(i.i.d)数据(如图像)上取得巨大成功的启发,团队研究了图神经网络(GNN),以便将深度神经网络泛化为图结构数据模型。图神经网络在金融、医疗保健和社会分析等各个领域的各种应用中都表现出了卓越的性能。GNN 的成功依赖于信息传递机制,即通过聚合来自邻居的信息来更新节点表示。通过这种机制,节点表征可以捕捉节点特征、邻居信息和本地图结构,从而促进节点分类、链接预测和图分类等各种图挖掘任务。

尽管 GNN 在图建模方面取得了成就,但人们对 GNN 可信性的担忧也在增加。首先,GNN 模型容易受到攻击,从而窃取私人数据信息或影响模型的行为。例如,黑客可以利用节点的嵌入来推断节点的属性信息和社交网络中的友情信息。他们还可以通过向网络中注入恶意节点,轻松骗过 GNN,为节点提供目标预测。其次,GNN 模型本身存在公平性和可解释性问题。更具体地说,GNN 模型会放大训练数据中的偏差,造成对特定性别、肤色和其他受保护敏感属性人的歧视。最后,由于模型的高度非线性,GNN 的预测结果难以理解。缺乏可解释性也使得 GNN 不可信,这在很大程度上限制了 GNN 的应用。这些弱点极大地阻碍了 GNN 在现实世界中的应用,尤其是在金融和医疗保健等高风险场景中。因此,如何建立可信的 GNN 模型已成为一个焦点话题。

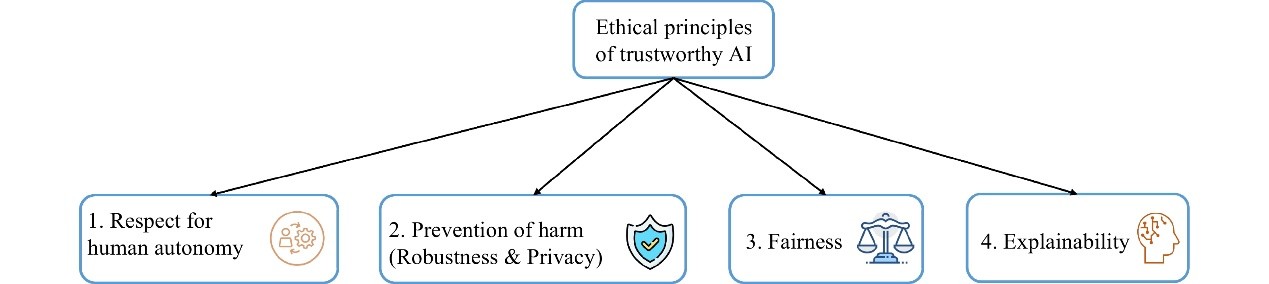

最近,欧盟提出了可信人工智能系统指南。如图 1 所示,该指南指出可信人工智能应遵守以下四项伦理原则:尊重人类自主性、防止伤害、公平性和可解释性。尊重人类自主性原则要求人工智能系统遵循以人为本的设计原则,为人类留出有意义的选择机会。这在人机交互领域通常是行不通的。因此,在本次调查中,团队并不关注可信 GNN 的这一方向。根据预防伤害原则,人工智能系统在技术上应该是稳健的,并确保不会被恶意使用,这与团队调查中的稳健性和隐私性方面相对应。公平原则要求人工智能系统应确保个人和群体免受不公平的偏见、歧视和侮辱。至于可解释性,它要求人工智能的决策过程是透明和可解释的。值得一提的是,这四个方面并不是相互孤立的。例如,攻击者可能会在训练数据中下毒,以降低模型的公平性或误导 GNN 解释器模型。而可解释 GNN 方法的解释也有助于其他方面。具体来说,根据可解释 GNN 模型的解释,人类可以对模型进行调试,以避免对抗性攻击。此外,通过对解释的分析,团队还可以评估所部署的模型是否给出了有偏差的预测。因此,团队认为有必要探索这些方面之间的联系,最终实现可信的 GNN,同时解决鲁棒性、隐私性、公平性和可解释性等问题。在本调查中,团队还讨论了未来方向中可信度各方面的相互作用。

图 1 可信人工智能的伦理原则

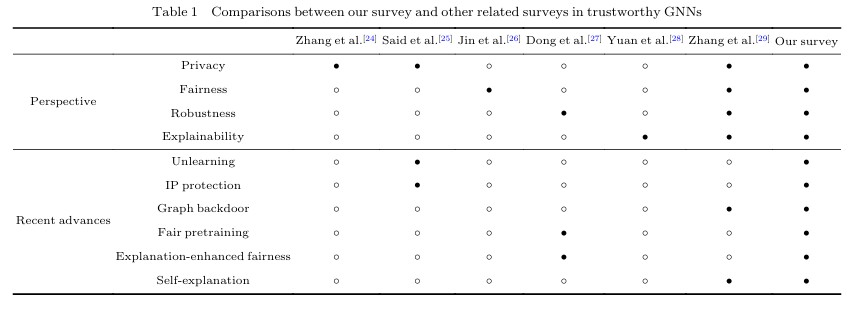

由于对可信 GNN 的需求,近年来出现了大量关于可信 GNN 不同方面的文献。例如,针对攻击者扰动的鲁棒 GNN 已被开发出来。为了防止隐私信息泄露,在金融分析等各种实际应用中也提出了保护隐私的GNN 模型。公平 GNN 和可解释 GNN 也成为解决可信性问题的热门话题。关于 GNN 在鲁棒性、可解释性和公平性方面的研究有很多。但是,这些研究都没有深入讨论 GNN 的可信度,而 GNN 的可信度还应包括隐私性和公平性两个方面。在鲁棒性和可解释性方面,它们也没有包括本调查所讨论的可扩展攻击、后门攻击和可自我解释的 GNN 等新兴方向和技术。最近的一项调查对可信人工智能系统进行了综述。但它主要关注的是 i.i.d 数据上的可信人工智能系统技术。考虑到图拓扑的复杂性和图神经网络中消息传递机制的部署,为 i.i.d 数据设计的可信人工智能一般无法用于处理图结构数据。目前对可信图神经网络的研究较多。表 1 对现有调查进行了更全面的比较。

表 1 团队的调查与其他相关调查在可信 GNN 方面的比较

主要贡献:

在第 3 节中,全面介绍了在 GNN 上进行隐私攻击和防御的工作,随后介绍了未来的发展方向。此外,还列出了隐私领域的图数据集。

第 4 节讨论了针对 GNN 模型的各类对抗性攻击和防御方法。还进一步介绍了有关 GNN 鲁棒性的一些最新进展,如可扩展攻击、图后门攻击和自监督学习防御。

第 5 节深入讨论了可信 GNN 的公平性,包括图结构数据的偏差和公平性定义、各种公平 GNN 模型及其应用的数据集。

第 6 节介绍了对 GNN 可解释性的全面调查,其中团队回顾了现有工作所采用的动机、挑战和实验设置。此外,还介绍了方法论的分类摘要。

本文作者

全文下载:

A Comprehensive Survey on Trustworthy Graph Neural Networks: Privacy, Robustness, Fairness, and Explainability

Enyan Dai, Tianxiang Zhao, Huaisheng Zhu, Junjie Xu, Zhimeng Guo, Hui Liu, Jiliang Tang, Suhang Wang

https://link.springer.com/article/10.1007/s11633-024-1510-8

https://www.mi-research.net/article/doi/10.1007/s11633-024-1510-8

BibTex:

@Article{MIR-2023-10-217,

author={Enyan Dai and Tianxiang Zhao and Huaisheng Zhu and Junjie Xu and Zhimeng Guo and Hui Liu and Jiliang Tang and Suhang Wang},

journal={Machine Intelligence Research},

title={A Comprehensive Survey on Trustworthy Graph Neural Networks: Privacy, Robustness, Fairness, and Explainability},

journal={Machine Intelligence Research},

year={2024},

volume={21},

issue={6},

pages={1011-1061},

doi={10.1007/s11633-024-1510-8}}

∨

关于Machine Intelligence Research

Machine Intelligence Research(简称MIR,原刊名International Journal of Automation and Computing)由中国科学院自动化研究所主办,于2022年正式出版。MIR立足国内、面向全球,着眼于服务国家战略需求,刊发机器智能领域最新原创研究性论文、综述、评论等,全面报道国际机器智能领域的基础理论和前沿创新研究成果,促进国际学术交流与学科发展,服务国家人工智能科技进步。期刊入选"中国科技期刊卓越行动计划",已被ESCI、EI、Scopus、中国科技核心期刊、CSCD等20余家国际数据库收录,入选图像图形领域期刊分级目录-T2级知名期刊。2022年首个CiteScore分值在计算机科学、工程、数学三大领域的八个子方向排名均跻身Q1区,最佳排名挺进Top 4%,2023年CiteScore分值继续跻身Q1区。2024年获得首个影响因子(IF) 6.4,位列人工智能及自动化&控制系统两个领域JCR Q1区。

▼往期目录▼

2025年第1期 | 机器视觉、机器人、神经网络、反事实学习、小样本信息网络...

2024年第6期 | 图神经网络,卷积神经网络,生物识别技术...

2024年第5期 | 大语言模型,无人系统,统一分类与拒识...

2024年第3期 | 分布式深度强化学习,知识图谱,推荐系统,3D视觉,联邦学习...

2024年第2期 | 大语言模型、零信任架构、常识知识推理、肿瘤自动检测和定位...

2023年第6期 | 影像组学、机器学习、图像盲去噪、深度估计...

2023年第5期 | 生成式人工智能系统、智能网联汽车、毫秒级人脸检测器、个性化联邦学习框架... (机器智能研究MIR)

2023年第4期 | 大规模多模态预训练模型、机器翻译、联邦学习......

2023年第3期 | 人机对抗智能、边缘智能、掩码图像重建、强化学习...

2023年第2期 · 特约专题 | 大规模预训练: 数据、模型和微调

2023年第1期 | 类脑智能机器人、联邦学习、视觉-语言预训练、伪装目标检测...

2022年第6期 | 因果推理、视觉表征学习、视频息肉分割...

2022年第4期 | 来自苏黎世联邦理工学院Luc Van Gool教授团队、清华大学戴琼海院士团队等

2022年第3期 | 聚焦自然语言处理、机器学习等领域;来自复旦大学、中国科学院自动化所等团队

2022年第2期 | 聚焦知识挖掘、5G、强化学习等领域;来自联想研究院、中国科学院自动化所等团队

▼好文推荐▼

哈工大江俊君团队 | SCNet:利用全1X1卷积实现轻量图像超分辨率

下载量TOP好文 | 人工智能领域高下载文章集锦(2023-2024年)

上海交大张拳石团队 | 综述: 基于博弈交互理论的神经网络可解释性研究

专题好文 | Luc Van Gool团队: 基于分层注意力的视觉Transformer

澳大利亚国立大学Nick Barnes团队 | 对息肉分割的再思考: 从分布外视角展开

前沿观点 | Segment Anything并非一直完美: SAM模型在不同真实场景中的应用调查

自动化所黄凯奇团队 | 分布式深度强化学习:综述与多玩家多智能体学习工具箱

约翰霍普金斯大学Alan Yuille团队 | 从时序和高维数据中定位肿瘤的弱标注方法

精选综述 | 零信任架构的自动化和编排: 潜在解决方案与挑战

欧洲科学院院士蒋田仔团队 | 脑成像数据的多模态融合: 方法与应用

专题好文 | 创新视听内容的联合创作: 计算机艺术面临的新挑战

下载量TOP好文 | 人工智能领域高下载文章集锦 (2022-2023年)

引用量TOP好文 | 人工智能领域高引用文章集锦 (2022-2023年)

哈工大江俊君团队 | DepthFormer: 利用长程关联和局部信息进行精确的单目深度估计

Luc Van Gool团队 | 通过Swin-Conv-UNet和数据合成实现实用图像盲去噪

贺威团队&王耀南院士团队 | 基于动态运动基元的机器人技能学习

乔红院士团队 | 类脑智能机器人:理论分析与系统应用 (机器智能研究MIR)

南科大于仕琪团队 | YuNet:一个速度为毫秒级的人脸检测器

上海交大严骏驰团队 | 综述: 求解布尔可满足性问题(SAT)的机器学习方法

前沿观点 | 谷歌BARD的视觉理解能力如何?对开放挑战的实证研究

港中文黄锦辉团队 | 综述: 任务型对话对话策略学习的强化学习方法

南航张道强教授团队 | 综述:用于脑影像基因组学的机器学习方法

ETHZ团队 | 一种基于深度梯度学习的高效伪装目标检测方法 (机器智能研究MIR)

Luc Van Gool团队 | 深度学习视角下的视频息肉分割

专题好文 | 新型类脑去噪内源生成模型: 解决复杂噪音下的手写数字识别问题

戴琼海院士团队 | 用以图像去遮挡的基于事件增强的多模态融合混合网络

ETH Zurich重磅综述 | 人脸-素描合成:一个新的挑战

▼MIR资讯▼

致谢审稿人 | Machine Intelligence Research

专题征稿 | Special Issue on Subtle Visual Computing

征稿启事 | AIART 2025 Call for Papers

专题征稿 | Special Issue on Embodied Intelligence

专题征稿 | Special Issue on Transformers for Medical Image Analysis

MIR 优秀编委 & 优秀审稿人 & 高被引论文 (2023年度)

年终喜报!MIR科技期刊世界影响力指数跻身Q1区 (含100份龙年礼包)

双喜!MIR入选”2022中国科技核心期刊”,并被DBLP收录 | 机器智能研究MIR

https://wap.sciencenet.cn/blog-749317-1479294.html

下一篇:喜报 | MIR 首次入选中国科学院期刊分区表计算机科学类二区