精选

精选

脑读取设备引发伦理困境 —— 研究人员提议保护措施

联合国神经技术伦理会议代表制定了首套维护用户隐私的全球指导方针

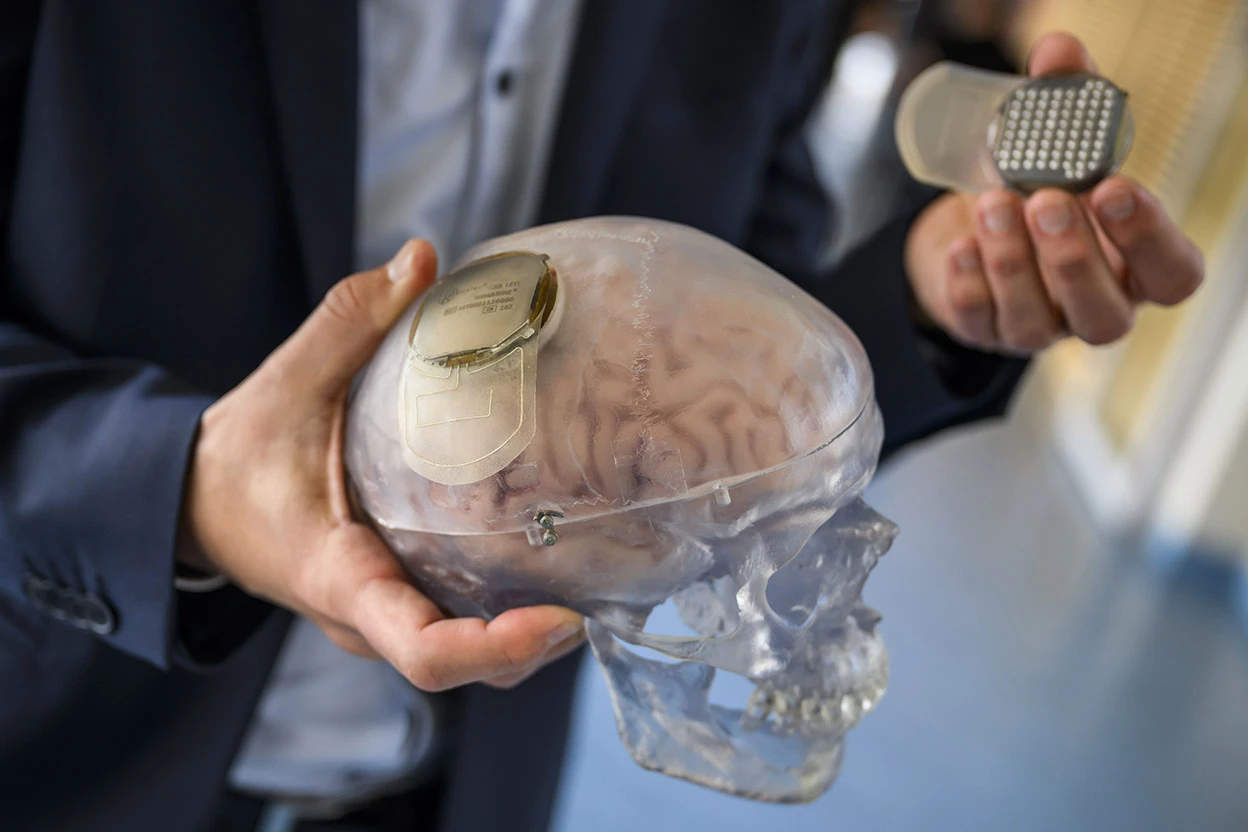

一个植入脑机接口的透明人类头骨模型。图片来源:Jean-Christophe Bott/EPA-EFE/Shutterstock

大约二十年前,安・约翰逊(Ann Johnson)因中风导致平衡、呼吸和吞咽能力受损,无法行走或说话。但在 2022 年,借助脑植入物,约翰逊终于通过虚拟化身听到了自己的声音。

这种植入物是过去五年进入人体试验的神经技术的一个范例。包括企业家埃隆・马斯克(Elon Musk)的 Neuralink 等研究团队和公司开发的这些设备,可以改变神经系统的活动,从而影响语言、触觉和运动等功能。上个月,联合国教科文组织(UNESCO)在巴黎主办的一次会议上讨论了这些设备,代表们最终确定了一套管理神经技术的伦理原则。

这些建议侧重于保护用户免受可能侵犯其人权(包括自主权和思想自由)的技术滥用。包括科学家、伦理学家和法律专家在内的代表们确定了九项原则,其中包括建议技术开发者披露神经信息的收集和使用方式,并确保产品对人们心理状态的长期安全性。

“这份文件阐明了如何保护人权,尤其是与神经系统相关的人权,” 圣地亚哥智利大学的神经科学家佩德罗・马尔多纳多(Pedro Maldonado)说,他是 2024 年起草这些建议的 24 名专家之一。这些原则不具有法律约束力,但各国和组织可以利用它们制定自己的政策。11 月,联合国教科文组织的 194 个成员国将就是否通过这些标准进行投票。

消费级设备

会议审议了一系列神经技术应用,包括设计用于植入人体的设备,以及正在医学、娱乐和教育领域探索的非侵入性设备。

美国和欧盟等地区已有针对植入式脑机设备的立法。但可穿戴设备等非医疗消费级设备的监管较少。剑桥麻省理工学院的神经技术专家娜塔莉娅・科斯米娜(Nataliya Kosmyna)帮助起草了这些建议,她说,由于这些设备可能迅速扩大规模,因此引发了伦理担忧。“了解这些设备的基础设施和可扩展性非常关键,” 她说。

每种应用都引发了特定的担忧。例如,在教育环境中,代表们建议禁止使用神经技术以可能加剧不平等的方式评估学生或教育工作者的表现。

对非侵入性设备的另一个担忧是,眼动和语音语调等信息可能被用来推断神经数据,包括某人的精神状态或大脑活动。代表们希望监管的一个潜在应用涉及神经营销,即操纵一个人的神经过程,以影响其对商业广告或政治信息的决策。专家们担心,这种活动可能在用户不知情的情况下发生 —— 例如在他们睡觉时,未经适当同意就进行。

德国慕尼黑工业大学的伦理学家、会议专家马塞洛・因卡(Marcello Ienca)说,商业神经设备已经构成数据和安全风险,尤其是对 “精神隐私” 的威胁。“关于大脑和思维的数据应受到更高的保护,以防止未经授权泄露精神信息,” 他说。

知情同意

保护精神隐私的一种方法是通过用户同意。联合国教科文组织的建议指出,这些同意需要是 “事先、自由和知情的”,并应包括随时退出使用技术的选项。

但华盛顿特区乔治・华盛顿大学的技术伦理学家维克拉姆・巴尔加瓦(Vikram Bhargava)认为,知情同意并非万无一失,他未参与此次会议。“这些神经数据不仅提供关于你的信息,还可能提供关于其他具有相似神经特征的人的信息,” 他说。

其他人则持不同意见。“人们思维方式的相似性更多与他们生活的地方、生活方式有关,而不是与他们大脑的运作方式有关,” 马尔多纳多说。

尽管如此,北卡罗来纳州达勒姆杜克大学的法律学者和伦理学家妮塔・法拉哈尼(Nita Farahany)说:“拥有各国承诺遵守的全球标准非常有力量。”

但美国在人工智能等领域放松监管的趋势表明,法律工具可能不是解决方案。相反,法拉哈尼说,各国应鼓励开发者设计为用户提供更多保护的功能。

转载本文请联系原作者获取授权,同时请注明本文来自孙学军科学网博客。

链接地址:https://wap.sciencenet.cn/blog-41174-1488393.html?mobile=1

收藏