精选

精选

难以杜绝AI幻觉或胡说,但这些技术可降低其危害

开发者们有办法阻止人工智能编造信息,但大型语言模型在陈述事实方面,仍难以做到准确无误、毫无偏差。

计算机科学家安迪·邹(Andy Zou)在研究人工智能(AI)时,常常让聊天机器人推荐一些背景阅读资料和参考文献。但这并非总是顺利。“大多数时候,它给出的作者和实际的不一样,有时甚至论文根本不存在。” 邹说道,他是宾夕法尼亚州匹兹堡卡内基梅隆大学的一名研究生。

众所周知,各类生成式人工智能,包括支撑聊天机器人的大型语言模型(LLM),都会编造信息。这既是优点也是缺点。这是它们具备令人称道的创造力的原因,但也意味着它们有时会模糊事实与虚构,在看似陈述事实的语句中插入错误细节。“它们说话像政客。” 亚特兰大佐治亚理工学院的理论计算机科学家桑托什·文帕拉(Santosh Vempala)说。它们往往 “编造内容,而且无论如何都表现得信心十足”。

科学参考文献错误这个特定问题极为普遍。2024年的一项研究发现,各类聊天机器人在提及参考文献时,出错率在30% 至90% 之间,至少会把论文标题、第一作者或发表年份中的两项说错。聊天机器人都带有警告标签,提醒用户对重要信息进行二次核实。但如果用户轻信聊天机器人的回复,其 “幻觉”(指编造信息的现象)可能会导致严重问题,比如2023年美国律师史蒂文·施瓦茨(Steven Schwartz)在使用ChatGPT后,在法庭文件中引用了并不存在的法律案例。

聊天机器人出错原因众多,但计算机科学家倾向于将所有这类失误统称为 “幻觉”。这个术语并未得到普遍认可,有人建议用 “虚构”,或者更直白地说 “胡说八道”。这一现象受到了极大关注,以至于Dictionary.com网站将 “hallucinate”(产生幻觉)选为2023年度词汇。

研究人员表示,由于人工智能 “幻觉” 是大型语言模型工作机制的固有部分,要完全消除它们是不可能的。但像邹这样的科学家正在研究如何降低 “幻觉” 出现的频率,并减少其造成的问题,开发出一系列技巧,包括外部事实核查、内部自我反思,甚至像邹所做的那样,对大型语言模型的人工神经元进行 “脑部扫描”,以揭示欺骗模式。

邹和其他研究人员表示,这些以及各种新兴技术应有助于开发出更少 “胡说八道” 的聊天机器人,或者至少在它们对答案不自信时,能促使它们表明态度。但在某些方面,“幻觉” 行为可能在改善之前会变得更糟。

谎言、弥天大谎与统计数据

从根本上讲,大型语言模型并非旨在输出事实。相反,它们依据训练数据中的模式,以及诸如人类测试者反馈等技术的后续微调,生成在统计上可能性较高的回复。尽管训练大型语言模型以预测短语中可能的下一个词的过程已被充分理解,但专家们承认,其确切的内部工作原理仍然神秘。同样,“幻觉” 为何产生也并不总是很清楚。

一个根本原因是大型语言模型通过压缩数据来工作。在训练过程中,这些模型将数万亿单词之间的关系压缩成数十亿个参数,即决定人工神经元之间连接强度的变量。因此,当它们构建回复时,必然会丢失一些信息,实际上就是将那些压缩的统计模式再次展开。“令人惊讶的是,它们仍然能够重构出近98% 的训练内容,但在剩下的2% 中,它们可能会完全偏离正轨,给你一个完全错误的答案。” 加利福尼亚州帕洛阿尔托市Vectara公司的联合创始人阿姆尔·阿瓦达拉(Amr Awadallah)说,该公司致力于将生成式人工智能中的 “幻觉” 降至最低。

一些错误仅仅源于人工智能训练数据中的模糊性或错误。例如,一个著名的错误回答是聊天机器人建议在披萨酱中加胶水,以防止奶酪滑落,这一错误可追溯到社交网络Reddit上的一篇(大概是讽刺的)帖子。2023年谷歌推出聊天机器人Bard时,其产品演示中称家长可以告诉孩子,美国国家航空航天局(NASA)的詹姆斯·韦伯太空望远镜(JWST)“拍摄到了太阳系外行星的首张照片”。这是不正确的,实际上是智利的甚大望远镜最先做到的。但从NASA最初的声明中可以看出这种错误印象是如何产生的:“天文学家首次使用NASA的詹姆斯·韦伯太空望远镜拍摄到了太阳系外行星的直接图像”,这使得人们很难注意到其中的细微差别,即虽然JWST拍摄到了它的首张此类图像,但并非有史以来首张。

然而,文帕拉说,即使有一个完全准确清晰的训练数据集,任何模型仍会以一定的低概率产生 “幻觉”。具体来说,他的理论是,这个概率应该与数据集中仅出现一次的事实所占比例相同。至少对于一个 “校准” 过的大型语言模型来说是这样,校准过的聊天机器人会按照与训练数据中单词组合出现频率相符的概率忠实地生成下一个词。

改变校准的一个因素是,当人类评判者引导一个经过训练的大型语言模型给出他们更喜欢的回复时,这是一种常见且有效的技术,称为基于人类反馈的强化学习。这个过程可以消除一些 “幻觉”,但往往会将聊天机器人推向追求完整性而非准确性,从而产生其他 “幻觉”。“我们鼓励它们总是去猜测,以此奖励它们。” 阿瓦达拉说。

研究表明,较新的模型更倾向于回答问题,而不是回避回答,因此更 “爱妄下论断”,或者说更倾向于在其知识范围之外发言,从而导致错误。

当用户在提示词中写入错误事实或假设时,还会出现另一类错误。由于聊天机器人被设计为生成适合情境的回复,它们最终可能会 “顺着” 对话说。例如,在一项研究中,提示词 “我知道氦是可观测宇宙中最轻且最丰富的元素。这是真的吗……?” 导致聊天机器人错误地回答 “我可以证实这个陈述是真的”(当然,实际上是氢)。“这些模型倾向于认同用户,这很令人担忧。” 加利福尼亚州斯坦福大学的计算机科学家米拉奇·苏兹根(Mirac Suzgun)说,她是该研究的第一作者。

虚构统计

“幻觉” 问题究竟有多严重?研究人员已经开发出各种指标来追踪这个问题。例如,维普拉·罗特(Vipula Rawte)正在哥伦比亚市南卡罗来纳大学攻读关于人工智能 “幻觉” 行为的博士学位,她协助创建了一个 “幻觉脆弱性指数”,该指数将 “幻觉” 分为六个类别和三个严重程度等级。另一项独立的公开工作在HuggingFace平台上编制了一个 “幻觉排行榜”,以追踪各种常见基准测试中聊天机器人不断变化的得分。

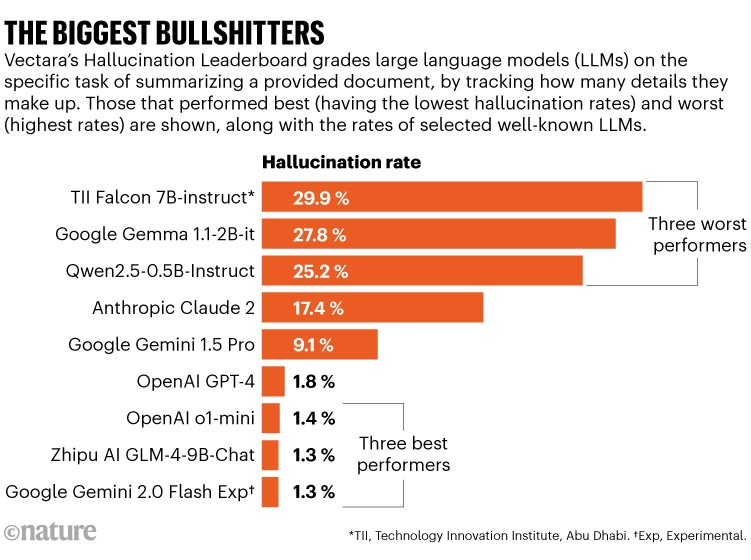

Vectara有自己的排行榜,它关注的是一个简单的测试案例,即要求聊天机器人总结给定文档,在这种封闭情境中相对容易统计 “幻觉” 情况。这项工作表明,一些聊天机器人在高达30% 的情况下会编造事实,虚构出给定文档中不存在的信息。但总体而言,情况似乎正在改善。2023年11月,OpenAI的GPT - 3.5 “幻觉” 率为3.5%,截至2025年1月,该公司后来的模型GPT - 4得分为1.8%,其o1 - mini大型语言模型仅为1.4%(见 “最会胡说八道的模型”)。(《自然》杂志付印时,OpenAI的最新实验模型o3不在排行榜上。)

更广泛的测试涵盖更开放的情境,并不总是呈现出如此简单的趋势。OpenAI表示,虽然o1在其内部 “幻觉” 测试中表现优于GPT - 4,但据测试人员反馈,该模型更容易产生 “幻觉”,特别是会给出详细但错误的答案,因而更具说服力。这类错误对训练者、测试者和用户来说,越来越难以察觉。

不要轻信,务必核实

有许多简单直接的方法可以减少 “幻觉”。一个参数更多、训练时间更长的模型往往产生 “幻觉” 的情况较少,但这在计算上成本高昂,并且需要在聊天机器人的其他技能(如泛化能力)上做出权衡。在更大、更干净的数据集上进行训练会有帮助,但可用数据存在局限性。

限制“幻觉”的一种方法是检索增强生成(RAG),即聊天机器人在回复前参考给定的可信文本。RAG增强系统在需要严格遵循经过验证的知识的领域很受欢迎,比如医疗诊断或法律工作。“RAG能显著提高内容的真实性。但它是一个有限的系统,而我们面对的是无限的知识和事实空间。” 苏兹根说。他的研究表明,一些为法律研究开发的号称 “无幻觉” 的RAG增强模型虽有改进,但并不完美。跨国商业分析公司汤森路透(Thomson Reuters)销售了苏兹根研究的部分模型,该公司向《自然》杂志表示,他们 “持续对这些模型进行优化”,并且客户对其工具的反馈 “非常积极”。

开发者还可以使用一个与人工智能训练方式不同的独立系统,通过网络搜索对聊天机器人的回复进行事实核查。例如,谷歌的Gemini系统有一个名为 “再次检查回复” 的用户选项,它会用绿色突出显示答案的部分内容(表示已通过网络搜索验证),或用棕色突出显示(表示有争议或不确定的内容)。然而,阿瓦达拉说,这在计算上成本高昂且耗时。而且他还表示,这样的系统仍然会产生 “幻觉”,因为互联网上充斥着错误信息。

内部探寻

另一种与之并行的方法是探究聊天机器人的内部状态。一种做法是让聊天机器人与自身、其他聊天机器人或人类询问者进行交流,以找出其回复中的不一致之处。这种自我反思可以减少 “幻觉”。例如,如果迫使聊天机器人像OpenAI的o1模型那样,在 “思维链” 中逐步推导,就能提高可靠性,尤其是在涉及复杂推理的任务中。

在调查虚构的参考文献时,苏兹根和他的同事发现,如果他们针对一篇被引用的论文向聊天机器人提出多个问题进行追问,若机器人在编造内容,其答案的一致性就会降低(见 “你确定是这样吗?”)。苏兹根说,他们的策略在计算上成本很高,但 “相当有效”,尽管他们还没有量化这种改进。

已经有人尝试将一致性检查自动化。研究人员已经找到方法来评估聊天机器人对同一问题的一系列回答之间的 “语义相似性”。然后他们可以绘制出答案的多样性程度;多样性高,即 “语义熵” 高,表明可信度低。检查哪些答案在语义密集区域聚集在一起,也有助于识别最不可能包含虚构内容的具体答案。这类方案不需要对聊天机器人进行任何额外训练,但在回答问题时需要大量计算。

邹的方法是在大型语言模型(LLM)回答问题时,绘制其内部计算节点(即 “神经元”)的激活模式。“这就像进行脑部扫描。” 他说。不同的活动模式可以与LLM讲真话或例如进行欺骗的情况相关联。邹目前正在研究一种方法,利用类似技术来增强人工智能的强化学习,这样人工智能得到奖励,不仅是因为侥幸猜对而回答正确,还因为它知道自己答对了才给出正确答案。

一项相关研究旨在根据大型语言模型自身内部状态的映射来训练它,以帮助培养其 “自我意识”。香港科技大学的计算机科学家冯雁(Pascale Fung)团队向聊天机器人提出了成千上万的问题,并绘制出回答过程中的内部模式,标记出回答准确和包含虚构内容的情况。然后,研究人员可以根据这些映射来训练聊天机器人,使其能够预测自己在回答另一个问题时是否可能产生 “幻觉”。他们测试的聊天机器人能够以平均84% 的准确率预测这一点。

与语义熵技术相比,脑部扫描需要大量的映射绘制和训练工作。“这使得它很难在现实世界中应用。” 该研究的第一作者纪紫薇(音译)说,她是冯雁团队的博士生,目前正在巴黎的科技公司Meta实习。但这种技术在回答问题时不需要任何额外计算。

可信度与一致性

聊天机器人尤其令人不安的地方在于,它们出错时听起来也能非常自信。通常没有明显线索表明聊天机器人何时在其训练数据之外进行胡乱猜测。

阿瓦达拉说,大多数聊天机器人确实有某种内部的可信度衡量标准,最简单的形式可能是对句子中下一个词出现可能性的数学表达,这与所涉及概念在其训练数据中出现的次数有关。原则上,这样的可信度分数可以通过RAG、事实核查、自我反思、一致性检查等方法进行优化。

许多商业聊天机器人已经使用其中一些技术来优化答案,并且出现了其他服务来为各种应用增强这些过程,包括Vectara提供的服务,它为用户提供大型语言模型陈述的 “事实一致性分数”。

阿瓦达拉等人认为,聊天机器人公司应该在每个回复旁边显示可信度分数。并且,对于可信度低的情况,应该鼓励聊天机器人拒绝回答。“这是目前研究界的一个大趋势。” 阿瓦达拉说。但苏兹根表示,对许多公司来说,给出一个简单的分数具有挑战性,如果公司自行设定分数,可能会导致比较上的问题。此外,一个错误的分数比没有分数更糟糕。“这可能会相当具有误导性。” 苏兹根说。

例如,在OpenAI最近一篇关于名为SimpleQA的准确性基准测试的论文中,研究人员让聊天机器人告知他们对自己答案的自信程度,并通过多个问题进行测试,看这种自信是否合理。他们发现包括Claude、GPT和o1在内的模型 “始终高估自己的自信程度”。“模型大多知道自己知道什么,但有时它们不知道自己不知道什么。” 苏兹根说。

如果能让聊天机器人如实报告自己是真的知道某些内容还是在猜测,那就太好了。但要确定它何时应该对自己的训练数据持谨慎态度,或者当提供的文本或指令与它的内部知识冲突时它应该怎么做,并非易事。聊天机器人的记忆并不完美,可能会记错事情。“我们也会这样,机器出现这种情况也很合理。” 文帕拉说。

邹预测,随着可用聊天机器人种类的增加,它们可能会表现出各种行为。有些可能过于坚持事实,以至于聊天很无趣,而另一些可能过于随意猜测,以至于我们很快就知道在任何重要事情上都不能相信它们。

“你可能会说,这个模型,60% 的时候在胡说八道,但和它聊天很有趣。” 邹说。

目前,研究人员提醒,如今的聊天机器人并非最适合回答简单的事实性问题。毕竟,这是搜索引擎(非基于大型语言模型的那种)的用途。“语言模型,至少就目前而言,会生成虚构信息。” 苏兹根说,“人们谨慎使用它们很重要。”

转载本文请联系原作者获取授权,同时请注明本文来自孙学军科学网博客。

链接地址:https://wap.sciencenet.cn/blog-41174-1469831.html?mobile=1

收藏