博文

ChatGPT“智能”测试:ChatGPT 对逻辑学基本概念的“理解掌握”程度

||

[敬请读者注意] 本人保留本文的全部著作权利。如果哪位读者使用本文所描述内容,请务必如实引用并明白注明本文出处。如果本人发现任何人擅自使用本文任何部分内容而不明白注明出处,恕本人在网上广泛公布侵权者姓名。敬请各位读者注意,谢谢!

ChatGPT“智能”测试:ChatGPT 对逻辑学基本概念的“理解掌握”程度

程京德

笔者对 ChatGPT 功能进行第二次测试的报告,仅供参考。

测试数据:笔者本人准备的、逻辑学的(笔者认为的)全部最基本概念(总计70个)。

测试方法:针对每个概念向 ChatGPT 提问,每个概念仅测试一次。

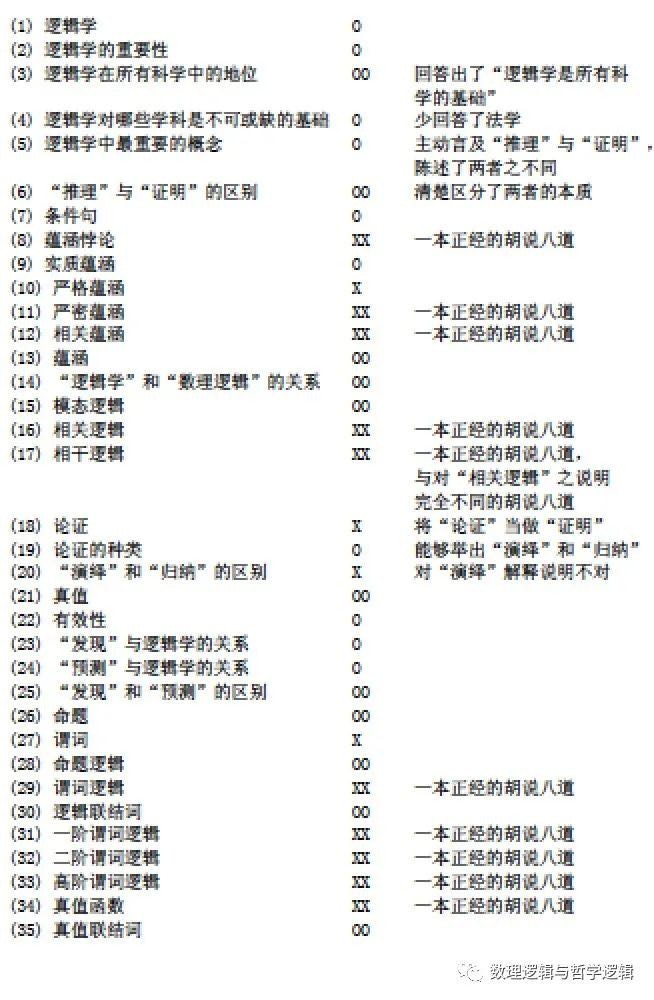

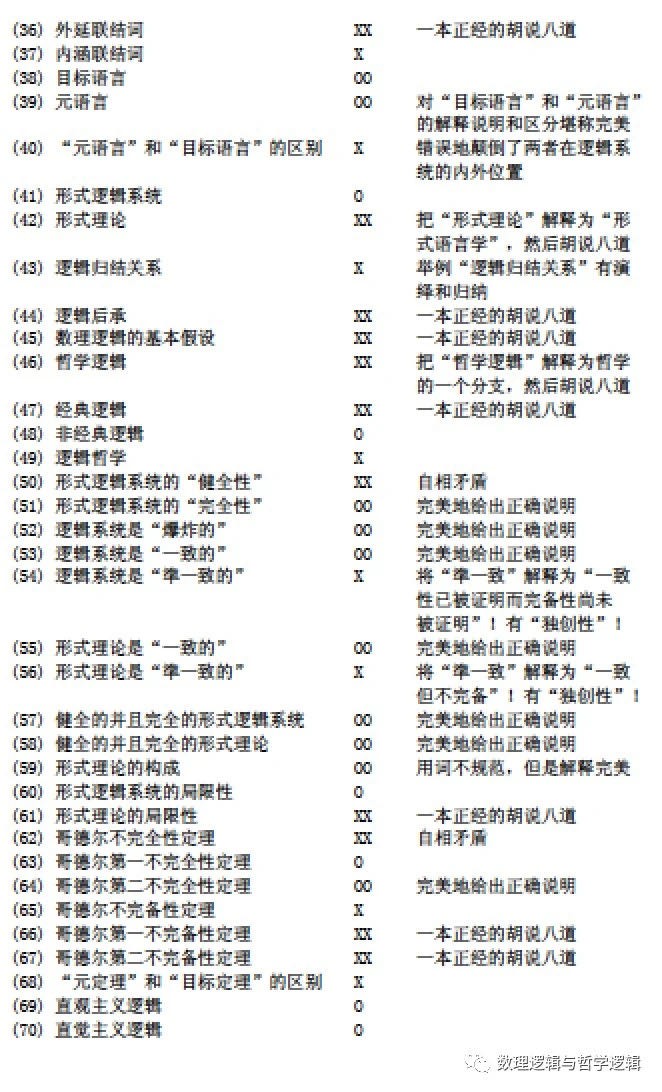

测试结果如下(OO表示很好,回答基本上完全正确,即便有多余的陈述但仅仅是冗余并没错;O表示合格,回答即便不够完整,但是没有错误;X表示不合格,回答中有错误,尽管可能也有对的成分;XX表示很差,回答错的离谱,毫无正确性可言):

序号 概念 评价 备注

正解率:OO: 21/70 (30%), O: 16/70 (22.86%), X: 12/70 (17.14%), XX: 21/70 (30%)。

笔者感想(仅限于此次测试实验):

(1)笔者的实验数据涵盖了逻辑学最基本概念之全部,无论对人还是对AI工具进行测试,都是对其“理解掌握”逻辑学基本概念之程度的合理测试。因为问题仅仅是对概念的知晓、说明的提问,所以,几乎不存在对自然语言陈述的“理解”能力问题,就是考查被询问对象对逻辑学基本概念的“理解掌握”程度。从整体上来说,ChatGPT 的回答(说明)一半以上是合格或者很完美的,应该说还是相当可以。如果与完全没有学过逻辑学的大学生相比,大概不弱于优秀的大学生,强于一般的大学生;如果与履修过正规的逻辑学课程/数理逻辑课程的大学生相比,大概弱于优秀的大学生,不弱于一般大学生,强于比较差的大学生。但是,ChatGPT 以目前的这种“理解掌握”程度显然还不足以被用作逻辑学教学辅助工具来“教”学生们正确的逻辑学知识。

(2)在 ChatGPT 的错误的回答(说明)中,也几乎没有语言陈述问题(尽管有自相矛盾问题),甚至错的很离谱的回答(说明),语言陈述也都很像模像样,完全可以“骗”过非逻辑学专业的人士。所以,笔者用了网上有人使用过的词汇来描述:“一本正经的胡说八道”。笔者相信,除了逻辑学领域,ChatGPT 的能力水平在其它领域大概也差不多。所以,打算使用 ChatGPT 来做科研做事业做生意的人们要千万当心,如果自己不具备相当的判断能力,十有八九会被它“骗”倒。

(3)对于逻辑学基本概念,ChatGPT 对单纯一个名词来表达的概念,回答正解率很高,但是,对于在名词前面添加了修饰词来表达的概念,则错误率很高。从回答的内容来看,笔者的感觉是,ChatGPT 主要是通过自己对词汇的“理解解释”和词汇的组合来作答,而不是首先去数据源里搜索答案的。因为,笔者列举的这些逻辑学概念,在网上,比如维基百科全书(百度不能算!)中应该都有相应的词条解释说明,如果搜索得来,肯定要比 ChatGPT 自己“创造”出来的靠谱。

(4)ChatGPT 表现出的另一个特点是,针对逻辑学同一概念的不同文字表达,比如“相关逻辑”和“相干逻辑”,“不完全性定理”和“不完备性定理”,它给出的答案(说明)可以相去甚远,而对于“直观主义逻辑”和“直觉主义逻辑”,它的回答(说明)却几乎一模一样。这种现象大概足以显示出 ChatGPT 的随机性。

(5)笔者给 ChatGPT 提出的概念问题都是成组的,相关的有联系的概念会以前后顺序提出。ChatGPT 表现出的另一个特点是,它可以对先出现的概念回答的相当不错,却对后出现的与这些概念相关相联系的问题,回答的根本不对,好像它实际上就没有“理解掌握”前面的概念。这种现象大概足以显示出 ChatGPT 的词语组合优先策略,应该不是 ChatGPT 的记忆功能的问题。

(6)世界上各行各业各种说法对 ChatGPT 的好评肯定有完全超出实际状况的(还有许多滥用AI概念的胡评就不论了)。通过对 ChatGPT 的两次测试,笔者感觉,所谓 ChatGPT 有意识、有理解能力、有逻辑思维能力等等的评价都是夸大其词、言过其实。要让 ChatGPT 真正具备语义处理能力大概还要有很长的路要走,仅仅基于 ChatGPT 目前的基本工作原理能否最终成功,还很难说。

笔者计划对 ChatGPT 的下一次测试是用数理逻辑的简单问题,本人的预测是 ChatGPT 大概会露出相当破绽。

微信公众号“数理逻辑与哲学逻辑”

https://wap.sciencenet.cn/blog-2371919-1376282.html

上一篇:ChatGPT“智能”测试:ChatGPT 对相关性逻辑谬误的判断

下一篇:ChatGPT“智能”测试:请您问问 ChatGPT 您自己的成就