精选

精选

如何对人工智能道德运气进行道德评价?*

李 伟1 李 侠2

(1.上海体育大学 马克思主义学院,上海,200438;2.上海交通大学 科学史与科学文化研究院,上海,200240)

摘 要:运气作为道德评价的要素之一,也应该被纳入人工智能的讨论中去。人工智能作为道德代理人对其行为应该负有道德责任,这不仅体现在人工智能应该对其能够控制的事负有道德责任,还应该对其不可控制的事,即在运气的影响下的行为负有道德责任。人工智能同样具有四种道德运气,分别为结果运气、间接运气、构成运气与因果运气。对于人工智能道德运气的评价,不能仅从动机论和结果论出发,而是需要寻找第三条进路将动机论和结果论相结合,特别是需要判断人工智能的动机、行为、结果是否具有连续的一致性,并在自我评价与社会评价作用下努力促使其自身不断进步。

关键词:人工智能;道德运气;动机论;结果论;一致性;评价

中图分类号:B82-057

当我们对某个人的行为进行道德评价时,是否应该将运气因素考虑进去?学者们对此抱有不同的观点,譬如,康德认为运气好坏不应被视作影响人们行为道德善恶的评价因素。虽然康德认为评价行为道德与否时应摒除运气,但有的学者认为对人们行为的道德判断与评价应该考虑运气,伯纳德·威廉斯(Bernard Williams)、托马斯·内格尔(Thomas Nagel)等哲学家从“道德运气”入手,认为人的行为无法免受境遇和运气的影响,这些不受行为者控制的因素不仅在人们的伦理生活中发挥着重要作用,而且影响着道德责任和道德评价。[[1]]

目前,对于道德运气的讨论日益丰富,但是这些讨论将重点放在人身上,伴随人工智能的快速发展,我们需要讨论如何对人工智能道德运气进行道德评价,只有这样,才能努力避免人们对人工智能行为道德评价的直觉性与主观性,如同牛津大学马里亚罗萨里亚·塔迪奥(Mariarosaria Taddeo)等人所述那样,预见方法能够在一定程度上应对人工智能带来的伦理风险,识别更好的替代方案、有价值的行动过程和缓解策略,避免道德上不可接受的决策或行为来帮助预防或减轻代价高昂的错误。[[2]]

需要说明的是,人工智能是一个宽泛的概念,而非狭窄的技术概念——适用于各种各样的自动化技术以及人工智能的应用。基于此,本文主要关注如下三个问题,首先,将道德运气引入人工智能领域的合理性以及受到运气影响的人工智能同样具有道德责任;其次,分析四种人工智能道德运气的表现及其特征;第三,对人工智能道德运气进行合理的道德评价的必要性与紧迫性。

一 是否应该将道德运气引入到人工智能领域?

我们可以期待人工智能在任何场景下都能做出理性决策,但有时运气也会让人工智能陷入困境。当人类做出决策时,所依据的行动准则不单被个人理性所指导,还掺杂着个人情感、价值观等。因此,当人们对他人做出道德评价时,不仅评价他人行为结果的好坏,同时还评价他人行为本身的善恶。如果事情的发展超出他的自我控制,那么人们就更加难以对他人的行为进行道德评价。

通常,人们都认为道德评价应该摆脱运气的干扰。但伯纳德·威廉斯对这个观点持反对态度,他认为“道德被认为摆脱了运气的影响。然而,一旦我们对这个观点持一种怀疑的态度,那么那个道德概念就不可能处于它原来所处的位置了。”[[3]]这也就意味着,人们行为的道德评价无法脱离运气来讨论。譬如,A邀请B去峡谷漂流,A和B分别乘坐不同的皮划艇。与A相比,B的皮划艇由于风力和水流的作用在一条水底岩石较多的路线漂流,B的皮划艇不幸被划破,B因此丧生。从这个例子可以看出,A和B同样是进行漂流,但由于B运气不好,最后丢失了性命。我们可以说如果B运气好一些也许就能避免这起事故。虽然A邀请B去漂流完全出于好心,即使不是他直接导致了B的死亡,但A或许会受到他人的指责。

从上述例子可以看出,现实生活中,当他人运气不好时,人们还是会责备坏的结果。如果把这种情形移入到人工智能领域中情况将怎样演变?这就涉及两个问题,其一,人工智能能够作为道德代理人存在吗?其二,人工智能会因为意外情况或者运气的影响受到责备吗?在探讨将道德运气移入到人工智能讨论之前,首先要解决的问题是人工智能能否被看作是道德代理人,如果这个问题不被解决的话,那么就无法进一步讨论在道德层面人工智能在运气的影响下是否应该被责备的问题。

凯尔·波格西安(Kyle Bogosian)认为在人工智能伦理中,虽然不同的人可能会倡导不同的道德体系,但不清楚哪一个系统最能实现任何人的特定价值体系,纯粹的道德分歧是无法克服的。[[4]]这就意味着,对于人工智能能否被看作道德代理人对不同的人而言观点是不同的。譬如,对于有的人来说,人工智能被看作道德代理人是值得怀疑的,就如文森特·穆勒(Vincent C. Müller)所认为的那样,在真正的人工智能中,通常没有一个人甚至可以说是道德地位的承载者。[[5]]另一种观点认为人工智能无法具有同人类一样的感性思维,没有拥有感情的能力,也就无法对道德负责。如牛津大学的卡丽莎·韦利斯(Carissa Véliz)将人工智能看作是一种功能性道德僵尸,不能自主也不负责任的主要原因是它们缺乏感性,缺乏必要的道德理解来对道德负责。[[6]]

虽然上面提到的学者对人工智能是否被看作道德代理人提出质疑,但是也有学者发出相反的声音,如丹尼尔·B·肖恩克(Daniel B.Shank)等人则通过研究发现,在解决人工智能是否因违反道德而受到指责时,人们在出现道德问题后将错误增加归咎于人工智能。[[7]]帕特里克·卡梅兹(Patrick Gamez)等人也发现,人们对于人工智能犯错的态度并没有站在一种客观的立场。[[8]]有的学者则认为人工智能也必须为其错误买单。如丹尼尔·W·蒂加德(Daniel W. Tigard)表示虽然人工智能无法像人类一样受苦,但考虑到当今人工智能系统中现有的感官和计算能力的复杂性,有理由认为机器将能够识别和学习人类的道德态度和行为,就目前而言,可以让一些机器承担责任。[[9]]

虽然学者们对人工智能是否应该被视作道德代理人持不同的观点,但是本文倾向于人工智能应该被视作道德代理人。我们知道人工智能决策和人类决策有所不同,人工智能无法拥有同人类一样的大脑。但是人工智能同人类一样,可以对输入的内容进行输出,以此形成自我决策。人们对自己的行为负责的一个条件在于人们具有自由意志,即具有自我思考的能力。人工智能在未来能够理解各个行为的关系,并对这些行为进行排序。同时,人工智能在与人类交往的过程之中可以学习人类的情感、道德判断等能够反映人类本质的东西。可以大胆预测,随着技术的进步,人工智能也会变得具有意识,同时能够感受到痛苦,并具备人类一样的欲望。因此,人工智能就可能具有自由意志,在确定场景下的人工智能的行为就必然需要负起道德责任。关于自由意志问题还需要深入推进一步,哲学家们普遍认为如果决定论是真的,那么我们就没有自由意志,如果回到亚原子层面又会怎样呢?美国哲学家丹尼尔•丹尼特认为:“得益于量子物理学家们的研究成果,科学家普遍认为(在亚原子层面)非决定论是真的,这似乎是一个圆满的解决方案……自由意志基于非决定论,亚原子非决定论究竟是如何产生自由意志的?这或许是神经科学家或者物理学家分内的事。”[[10]]人工智能在内部亚结构的功能上仍然是不清晰的,从这个角度来说,未来人工智能将有自由意志也不是不可想象的事情。那么,当道德运气遇到人工智能会发生什么呢?

当我们对运气影响进行分析时,可以发现,运气分析的一个重要的特点就是发生了意外情况,或者说是运气对行为和后果产生了影响。根据我们的理解,如果某件事超出了我们的控制范围,并且改变了我们的责任程度,那么它就是道德运气。[[11]]托马斯·内格尔坚定地认为人们应该对运气导致的行为后果负责,就像他所说的那样:“一个人都要对自己实际做的事情负责——即使一个人实际做的事情在很大程度上取决于不在自己控制范围内的事情。[[12]]那么,如果按照内格尔的说法,人们可以对在运气的影响下的行为进行道德评价,同样的,人工智能作为道德代理人也需要对自己的行为负责,即使其行为被运气所影响。因此,我们可以认为道德运气能够被引入到人工智能的讨论中去。

二 人工智能道德责任与道德运气

当我们对人类进行道德评价时,根植于每个人心中的道德观念都在发挥作用,但当我们对人工智能进行道德评价之前,首先便会陷入是否应该对人工智能进行道德评价的困境。虽然有人会质疑人工智能道德的合理性,但不可否认的是人们可以通过将特定的道德算法把人类的道德规则植入人工智能,不仅如此,随着人工智能的大量普及,人工智能或许会产生新的道德,这个阶段或许不会那么快到来,但有一点可以确定,到目前为止,人类和机器人作为不同物种(自然的和人工的)的成员,且有不同的道德观之间的关系已经能够建立。[[13]]

既然人工智能具备道德可能性,那么人工智能是否具有道德责任?对于人工智能道德责任分析的重要性关乎对于人工智能的道德运气的分析。如果我们通过论证发现人工智能不具备道德责任,那么对在不可控条件下,即运气影响下的人工智能行为道德责任的讨论就无从谈起。

学者们是如何看待人工智能是否能够对自己的行为承担道德责任?虽然,阿比盖尔·威尔逊(Abigail Wilson)等人通过研究发现,当人工智能犯道德错误时,人们不是责怪人工智能或将这些行为视为故意,而是转移到责怪开发人工智能的人身上。[[14]]但是,人工智能通过数据和自己的智能算法做出决策。人工智能输入数据和分析可以被视为人类日常生活经验的提取和总结。因此,可以看出,人工智能决策需要与自己的算法和数据输入直接相关,就像人类根据经验做出判断和行为一样,从而促进自己的决策并实施自己的行为。与威尔逊研究相反,南加州大学的洪柱华(Joo-Wha Hong)等人通过研究发现,人们倾向于相信人工智能会比人类做得更好、更准确、更安全。因此,当人工智能偏离人们的期望时,会导致更多的指责,如果人工智能被认为是一个类似于人类的代理人,那么对人工智能不同程度的责备是可以预见的。[[15]]

那么,人工智能是否需要为自己的行为负责呢?笔者认为,人工智能需要为自己的行为负责。休谟指出“我们感觉到,在多数场合下,我们的行动受我们意志的支配,并想像自己感觉到意志自身不受任何事物支配;因为当人们否认这点、因而我们被挑激起来亲自试验时,我们就感觉到意志容易地在每一方面活动,甚至在它原来不曾定下来的那一面产生了自己的意向。”[[16]]这也就意味着,当且仅当人类是自身行动的源泉,是自身意志的决定,在此基础上,人类才能自由行动。除此之外,当人类行为将这种自由反映在他自身时,人类才能被看作能够承担道德责任。那么,如果我们按照休谟的观点对人工智能是否应该承担道德责任继续推进,人工智能所表达的自由通过数据整合与算法进行分析,并在此基础之上做出决策,在这个过程中,虽然人工智能即使没有同人类一样的意志,但是也能看出人工智能在其行为过程中体现出来一定的目的性,存在一个终极目的,如护理机器人通过对陪伴老人的日常数据进行分析,推测出老人的下一个决定是散步,那么,我们就可以说护理机器人这种人工智能的终极目的是陪老人散步。护理机器人具有自身意志,并且这种意志反映在其行为之上,那么在此案例中,护理机器人应该对自己在护理老人时的行为负责。因此,人工智能具有承担道德责任的可能性。

伍玉林指出计算机“大量的突发性及不确定性”恰好与道德运气现象不谋而合。[[17]]那么当我们在第一部分论证过能够将道德运气引入至人工智能的讨论中以及人工智能也需要负道德责任之后,我们所要解决的问题是如何评估人工智能会受到哪些运气的影响。本文将会引入托马斯·内格尔所区分的四种道德运气,并论证是否能将这四种不同类型道德运气纳入人工智能的讨论之中。基于此,才能继续探讨如何对人工智能的道德运气进行道德评价。

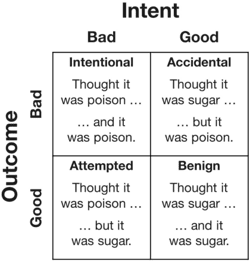

朱利奥·梅卡西(Giulio Mecacci)等人认为,当事情出错,身体完整或生命等重要利益或权利受到侵犯时,我们不仅想了解发生了什么以及为什么发生。我们还想知道伤害是否是某人错误行为的结果,如果事实证明错误行为是没有正当理由或借口的行为,我们希望人们因其行为而受到谴责、制裁甚至惩罚。[[18]]这种观点具有较强的道德直觉性,意味着一个人是否应该受到责备取决于其行为是否故意或是否在预料之中,这被称作为控制原则。值得补充的是,缺乏控制条件可能会使这个问题与某些道德责任观点背道而驰。尼尔·利维(Neil Levy)举了一个例子,如果一个朋友没有祝他生日快乐,朋友应该受到一些责备。但如果他发现朋友只是忘记了,这种直觉就会消失。很容易看出,这种观点如何因缺乏足以带来道德运气的控制条件而惹麻烦。[[19]]但是,托马斯·内格尔认为,尽管人们会缺乏控制,但是人们的行为仍然能够被视为道德判断对象。即由于不可预测的因素的干扰,人们或许会无法控制自己的行为导向而导致不好的事情发生,这些不可预测的因素通常被分为四类,分别是结果运气、间接运气、构成运气以及因果运气。下面将会从人工智能的角度思考这四种道德运气对道德评判的影响。

首先,我们需要分析人工智能是否具有结果运气。对于内格尔而言,结果运气是由此产生的运气是事情结果的运气,即在不确定情况下做出的决策,依据结果来判断决策者是否需要被责备或赞赏。针对结果运气的描述,当我们在思考人工智能时,可以举出许多例子,因为人工智能即使出于同样的意图、目的,并且行为也相近或者一致,但是还会出现不同的结果。也就是说人工智能也面对同人类一样的“不确定下的决策”导致不同的结果,这将会影响人们对它们的道德评价。譬如,两辆同型号自动驾驶汽车行驶在两条道路之上,突然,一个小孩从路边的绿化带中冲了出来,其中一辆自动驾驶汽车撞到了小孩;但是另外一辆自动驾驶汽车行驶的道路上并没有出现小孩,因此也就没有发生事故。通过这个例子可以发现人工智能会遇到结果运气的情况,因此,内格尔所述的结果运气对于人工智能也是适用的。

其次,我们需要分析人工智能是否具有间接运气,这也被称为环境运气。对于内格尔而言,间接运气是发现自身处于什么样环境的运气。让我们试想一下存在两个不同的人工智能,一个人工智能出产于技术先进、资金充沛的大型科技公司;另外一个人工智能出产于技术一般、资金不太富裕的小型科技公司。那么,第一个人工智能无论是在分析能力、响应速度及智能化等都超过第二个人工智能。因此,当这两个人工智能完成同一项的任务时,第一个人工智能将会比第二个人工智能完成得要更为出色,更能让人满意,而第二个人工智能相较于第一个人工智能或许会受到更多责备。但是,我们试想一下,如果第二个人工智能被转交到第一个人工智能的公司,在该公司的努力下,第二个人工智能或许会达到第一个人工智能那种能够被人们所认可的程度。这种情况下,不同的人工智能根据不同场景中各自的位置而面临着不同的道德判断。通过这个例子可以发现人工智能会遇到间接道德运气的情况,显然内格尔所述的间接运气对于人工智能也是适用的。

再次,我们需要分析人工智能是否具有构成运气。对于内格尔而言,构成运气就是人的特质和性格上的运气。对于人类而言,人的特质和性格会因为遗传、家庭、社会的不同而不同,人们因为自身接触的不同产生不同特质,这也造就了现在的自己。那么对于人工智能而言,其必然也受外界的影响,比如,两个机器人由于在自身被设计的过程中输入的数据量不同,算法不同,输入的数据来源不同等都会造就自身不同的特质。其中一个受利己主义倾向的文本训练集会使其在做事时更多体现为以利己为导向的性格,如自私,而另一个受利他主义倾向的文本训练集会使其在做事时更多体现为以利他为导向的性格,如慷慨。同时,这两个机器人在同人类或者其他机器人互动的过程中,也会学习相应的思考方式与学习方式,反映出来的就是不同的性格或特质。当人们赞美或指责机器人因其特质展现出来的行为时,机器人的存在确实依赖于他们所无法控制的因素。通过这个例子可以发现人工智能也会遇到构成道德运气的情况,因此,内格尔所述的构成运气对人工智能也是适用的。

最后,我们需要分析人工智能是否具有因果运气。对于内格尔而言,因果运气就是由先前的行为决定的运气或后果。关于因果运气,本质上是对自由意志问题的进一步探讨,内格尔认为,我们的行动,注入那些被撕裂的意志行为都显现出那些我们无法控制的后果。正因为如此,如果将意志自由作为道德责任的必要条件,那么人们都不会想要承担责任,毕竟不可控制因素导致我们的自由意志被销毁。简而言之,后果或行为是一直无法控制的前因的产物。让我们来思考一下这样一个警察机器人,这个警察机器人接到了一个任务去逮捕一个嫌疑犯。当他到达指定地点,他发现嫌疑犯的女儿也在嫌疑犯身边,这种情况是这个警察机器人所预料之外的。因此,出于对小女孩保护的考虑(当面抓捕他父亲或许会给其留下心理阴影),警察机器人打算在小女孩离开之后进行抓捕行动。也正是因为这个小女孩的意外出现,导致错过了最佳抓捕时间从而嫌疑犯逃脱,因此警察机器人受到人们的责备。在上面这个例子中,坏的结果不仅是由于意外的出现,还由警察机器人的怜悯心所导致,也就是内格尔所认为的先前的行为或因素在一定程度上导致后面的结果。通过这个例子可以发现人工智能同样会遇到因果运气的情况,因而,内格尔所述的因果运气对人工智能也是适用的。

综上所述,人工智能即使在运气的影响下也要对自身的行为负有道德责任,同时,托马斯·内格尔所提出的四种道德运气对于人工智能也是同样适用的。那么如何对人工智能的道德运气进行道德评价呢?

三 人工智能道德运气的道德评价

道德评价是一种善恶判断,在一定程度上能够对人们的行为起到一种规范作用。这体现在两个方面:当人们赞赏某种行为时,被评价人会被激发一种积极态度,将会保持并且加强那些善的行为;当人们批评某种行为时,被评价人的行为会被他人所抵制,将会取消或者减少那些恶的行为。但是,当人们内心具有道德情感时,由于每个人的道德情感以及所秉持的伦理判断准则所不同,那么他们对于道德评价也是不同的。这种情况常见于日常生活中对他人行为的判断之中,特别是,当道德运气介入之后,如何对道德运气下的人工智能行为进行道德评价变得愈发棘手起来。

对于某人的道德评价,伦理学通常分为两派,一派倡导动机论,另一派倡导结果论。动机论以康德为代表,认为善的行为取决于动机,即该行为在本质上是对的还是错的。结果论以边沁与密尔为代表,认为善的行为取决于后果,即该行为能否最大化善或者最小化恶,能够达到“最大多数人的最大幸福”。动机论和结果论作为常用的道德评价方法,乍看之下每个方法都有自身的道理,但如果单独依据这两套理论来解决现实生活中的问题就会陷入两难境地。归根结底,动机是人们行为之前的一种主观愿望,而结果是人们行为之后的客观结果,这就造成了动机论与结果论的道德评价的不一致性,这里揭示出原有道德理论存在巨大的缺陷,即行为过程被道德评价忽略了。因此,我们需要通过第三条进路来处理人工智能道德运气的道德评价问题。在此之前,我们首先需要利用动机论及结果论对人工智能四种道德运气进行道德评价,并观察如果这么做会出现什么问题。

对于人工智能的结果运气,就如同上面所举的例子那样,两辆自动驾驶汽车在行驶过程中因为小孩的意外出现而导致了其中一辆自动驾驶汽车受到人们的责备。很显然,人们是从结果论的角度对自动驾驶汽车进行道德评价。我们需要注意,自动驾驶汽车其不仅具有工具价值,还存在内在价值,这也就意味着自动驾驶汽车有着内在善——安全将人送到目的地。如果从动机论来看待自动驾驶汽车,其动机是好的,那么此处以自动驾驶汽车作为例子的人工智能结果运气按照动机论和结果论评价就出现了矛盾。对于人工智能间接运气,本文举例了两个不同公司生产出来的机器人在使用时被人所赞扬和责备的情境。机器人由于自身的生产环境的不同导致二者在道德评价上有较大差别。我们可以发现,人工智能间接运气的真实情况和结果运气的情况几乎一致,人们在评价时还是出于结果论。同样的,如果从动机论来讨论人工智能的间接运气,人工智能因为环境不同所呈现出来的赞赏或责备的不同不应该被视为正当的,就如同动机论所想表达的那样,不同环境下生产出来的人工智能如果其被生产的动机是为了使人类的生活变得更加好,那么在道德评价上就是值得被赞扬的,即使他们二者的能力具有较大的差异。对于人工智能的构成运气,也就是人工智能的性格或特质会因自身的构成不同而不同,从上面所举的机器人的例子可以看出,从构成运气角度对人工智能进行道德评价时,主要从动机论进行关注,包括文中所列举的利己主义与利他主义。但是这么评价也会出现问题,特别是如果一个利己主义的人工智能最终造成利他的结果时,按照动机论的说法那么这个人工智能就不能说是善的。对于人工智能的因果运气,本文所举的例子是警察机器人因保护小女孩导致了嫌疑犯的逃脱。从结果论对警察机器人进行道德评价必然是不道德的,因为警察机器人的职能是抓捕嫌疑犯,但是,从动机论来看其行为,警察机器人出于善的动机,即出于考虑小女孩未来成长的角度,警察机器人行为也存在善的一面。因此,如果从结果论的角度来评价人工智能的因果运气也是不妥当的。

上文我们对人工智能道德运气进行了四种不同道德运气的道德评价,通过道德评价发现了动机和后果之间发生了矛盾,简而言之,就是运气的加入,使得动机和后果不一致。因此我们所要处理的难点在于如何平衡这种矛盾。为此,我们需要找到第三种评价进路,其所需要解决的问题是如何将动机论和结果论相结合。

好动机导致坏结果在日常生活中很常见,譬如,一个男子出于好心跳入水中试图抢救落水的孩童,但是最终结果却没能救上来,虽然结果不尽如人意,但是人们却总是对这种行为抱有敬意。康德认为“即使由于特别的时运不济,或者由于无情自然的苛待,这个意志完全丧失了实现其意图的能力,假如它尽了最大努力却对此仍然一无所获,只剩下这个善良意志(当然绝不是一个单纯的希望,而是用尽了在我们所能支配的范围内的一切办法):那么它毕竟会像一颗珠宝一样独自闪闪发光,它是某种在自己自身内就拥有其完全价值的东西。”[[20]]让我们回到与坏结果最相关的结果运气中的人工智能的运气讨论中来。首先我们确定了结果,即自动驾驶汽车撞到了小孩。对于自动驾驶汽车的动机,很显然是安全地将乘客送到目的地,很显然这个动机是好动机,但是由于撞到了小孩,或许会发生两种情况,第一种情况是由于该事故导致车内乘客受伤,第二种情况是车内乘客没受伤,小孩却受伤。倘若,在自动驾驶汽车平稳行进的过程之中到撞到小孩的这段时间内,自动驾驶汽车做出了以下选择,如尝试减速并且避让小孩或是采取其他能够保证车内乘客和小孩的安全的行为。那么,在此案例中我们可以判断出自动驾驶汽车这个人工智能的道德评价是善的。因为如果人工智能出于好的动机,必然努力使得自身动机与结果相一致,在事前就能预估事后的结果。但是,由于运气的存在,想要正确预估结果变得极为困难,因此这就必须分析动机后的行为,如果该行为和动机产生一致性,那么就算结果不尽如人意,如引发了坏的结果也不应该受到责备。如果我们真的这么想,那么当我们面对警察机器人所处的环境也会变得棘手起来。因为警察机器人也是出于好的动机(保护小女孩心理健康),但是导致了坏结果(嫌疑人逃脱)。这种情况下应该如何进行道德评价?

我们需要明白的是警察机器人不仅作为一种人工智能拥有自我意识,他还具有更为重要的责任,即警察社会责任,同时需要作为人类的帮手听从上级或者人类的命令。阿西莫夫第二定律表示机器人必须服从人类的命令,除非这些命令与第一定律相冲突。在这个例子中,显然警察机器人去逮捕嫌疑犯是善的命令。因此,作为警察机器人而言,其两种选择——保护小女孩和逮捕嫌疑人,其中应该以逮捕嫌疑人为首要目的。因此动机、行为、结果都应以逮捕嫌疑人为主,而保护小女孩为辅。虽然小女孩的意外出现使得警察机器人的预期发生了变化,但这并不意味警察机器人就必须放过嫌疑人。警察机器人可以妥善处理这个事件,如寻求同事的帮助,让同事将小女孩引开,再对嫌疑人进行抓捕。从这个例子可以看出,随着运气的加入,人工智能或许会偏离最初的计划轨道而导致错误的结果发生。因此,对于这类人工智能的因果运气,我们需要判断动机、行为、结果是否是连续的一致,同时应该判断人工智能是否按照人类善的要求或指示行动,才能对人工智能做出正确的道德评价。慕尼黑工业大学的丹尼尔·W·泰加德(Daniel W. Tigard)根据发生某事的来源或原因赋予了三种解释来概括人工智能的责任,其中所有格解释表明了人工智能有某种责任或义务,可能具有社会、政治或道德意义。[[21]]这也就意味着,警察机器人除了需要思考自身行为对小女孩的潜在影响,还要思考自身所承担的社会责任或者义务。

对于人工智能的间接运气与构成运气的道德评价与所提及的结果运气与因果运气的道德评价具有差异性。当我们在讨论间接运气与构成运气时,我们并不会将注意力放在人工智能的结果之上,因为,就如同上文对这二者所举出的例子那样,间接运气和结果运气所面临的困境是人工智能自身被生产的环境以及外界因素所影响的性格、特质导致自身功能的落后。因此,如果我们对这些似乎有些欠缺的人工智能给予道德责备或许是不被赞同的。在我们对这些人工智能进行道德评价时,我们应该分析的是,对于生产这些人工智能的厂商而言,是否出于善的动机。这些看似落后的人工智能无法完全满足人们的期望,但是如果他们出于善的动机,并且尽力做到更好,以求达到自身努力范围内的最好结果,那么我们对于这些人工智能的道德评价也应该是善的。这也就意味着,即使这些看起来相对落后的人工智能由于自身的出身虽然也许暂时会导致达不到人们的期望的结果,或者说是坏的结果,但是这些人工智能通过各种方式,例如自身的不断学习,又或者生产厂商的不断升级使自己逐步达到人们期待的程度,并且这种升级是一种不断持续向前的过程,即使中间受到阻碍,也应该在道德评价中是值得赞扬的。我们应该拒绝因关注行为的实际后果而产生的直觉,因为这些直觉是由不可靠的机制产生的。[[22]]因此,可以看出,对于人工智能的评价不能只在乎眼前所反映出来的结果,还需要分析动机,特别是与动机所协调一致的行为,并且这种行为是人工智能认识到自身的不足并且不断升级的一种状态或者过程。当然,这种分析也可以用于人工智能的结果运气及因果运气中。

不容忽视的是上述所谈及的如何对人工智能道德运气进行道德评价是站在社会评价角度,这种社会评价由非本体人工智能做出。但是,我们也不能忽视人工智能的自我评价。因为人工智能在认识到自己的不足通过各种方式促进自身进步以满足人们的愿望和社会期待的过程之中需要认识自我的不足,而认识自身的不足的过程就是人工智能对自我评价的过程。当然,也许会有人质疑,如果诸如警察机器人所采取的保护小女孩导致嫌疑人逃脱的情况时,警察机器人对自己的行为进行道德辩护,认为自己的行为是正确的情况下那么人工智能的正确自我批评将会出现扭曲。这种情况确实会发生,但是我们需要注意,虽然警察机器人会产生同社会评价所不一样的自我评价,但是社会评价将会正确评判警察机器人的行为,通过社会舆论,人工智能会达到正确的自我评价。动机、行为、结果、自我评价、社会评价糅合在一起,能够对人工智能的道德运气评价发挥作用。无论是我们如何对人工智能道德运气进行道德评价,我们所希望达到的最终目的是能够使人工智能在以后的行为中,无论是否出现运气的影响,都能够最大限度上保证好的动机达到好的结果,即使暂时达不到好的结果,也希望人工智能能够吸取经验、教训,通过自我的不断提高,在未来能够面对运气所出现的意外,完善自身以达到好的结果。考虑到历史上道德评价标准的变迁,我们还要警惕另一种情形,即不能把板子都打在人工智能的屁股上,由于特定时代人类认知的局限性,很有可能会出现人类道德评价标准的退化(或落后)或观念的路径依赖现象,反而是人工智能的道德评价标准更进步(或先进)的情况,此时我们需要把两者结合起来去做出道德评价,这种情况在人工智能领域已经出现,如围棋人工智能经常会走出一些人类无法理解的走法,这一定是人工智能错了吗?显然不是,回到文中提到的例子也是存在这种可能性的。

当人工智能道德运气摆在人们面前时,并不是简单的动机论与结果论的较量,更是复杂的动机和结果的分析。在对人工智能道德评价的过程中,我们应该注重分析人工智能的动机是否与行为相一致,并且关注人工智能其行为的结果是否被人所接受抑或能否达成人们对其所设定的最初的任务要求。在我们讨论人工智能道德运气的过程中,我们关注的是人工智能在运气介入后所发生的恶的结果问题,这个问题如此重要的原因在于我们希望人工智能出于善的动机能够达到善的结果,但是运气介入会使得人们对于人工智能的预想结果发生偏转。对于人工智能道德运气的道德评价,我们需要具体问题具体分析,而不是简单地,一味地机械套弄动机论和结果论,而是应该更加灵活地运用分析方法,给予运气引发的道德问题以客观、合理的评价。

结语

即使人类使用人工智能等技术采取自愿行动,也有许多情况、历史、制度等超出了我们个人甚至集体的完全控制范围之外,但仍然塑造了技术的所作所为。[[23]]运气的加入使得人工智能面临不可控制的意外情形,这也就意味着,人工智能并不能完全理性地应对各种情况,当不好的运气降临在他们身上时,我们应该知晓如何对他们进行道德评价。对于人工智能的道德评价不能陷入动机论与结果论的二分泥潭中,而是需要具体问题具体分析,通过将动机论与结果论相结合,并辅以对行为过程的考察,以求正确、客观地对人工智能进行道德评价。对于人工智能道德运气的道德评价如此重要,这关乎着我们对于人工智能今后发展的态度,同样关乎着人工智能未来的开发模式的道德取向,这不仅需要伦理学家不断努力,更需要如人工智能开发者与政策制定者等相关人士通力合作,只要这样,我们才能保证人工智能能够按照人们的愿景持续向善发展,为我们社会的进步做出贡献。

【参考文献】

* 【收稿日期】2024-

【基金项目】上海市哲学社会科学规划课题青年项目“救援机器人伦理研究”(2023EZX002);中国化马克思主义与传统文化研究中心资助项目“科技文化指引数字经济伦理有效治理体系研究”(ZMCY202301)。

【作者简介】李伟(1991-),男,四川资阳人,上海体育大学马克思主义学院讲师,研究方向为马克思主义伦理、科技伦理;

李侠(1967-),男,辽宁辽阳人,上海交通大学科学史与科学文化研究院教授,研究方向为科学哲学。

[[1]] 马寅卯.“道德价值”与“道德运气”[J]. 哲学研究,2020(4):100-111+125.

[[2]] TADDEO M, FLORIDI L. How AI can be a force for good[J]. Science, 2018, 361(6404): 751-752.

[[3]] 伯纳德·威廉斯. 道德运气[M] . 徐向东译,上海:上海译文出版社,2007:58.

[[4]] BOGOSIAN K. Implementation of moral uncertainty in intelligent machines[J]. Minds and Machines, 2017, 27(4): 591-608.

[[5]] MÜLLER V C. Is it time for robot rights? moral status in artificial entities[J]. Ethics and Information Technology, 2021, 23(4): 579–587.

[[6]] VÉLIZ C. Moral zombies: why algorithms are not moral agents[J]. AI&SOCIETY, 2021, 36(2) : 487–497.

[[7]] SHANK D B, DESANTI A. Attributions of morality and mind to artificial intelligence after real-world moral violations[J]. Computers in Human Behavior, 2018, 86: 401-411.

[[8]] GAMEZ P, SHANK D B, ARNOLD C, et al. Artificial virtue: the machine question and perceptions of moral character in artificial moral agents[J]. AI & SOCIETY, 2020, 35(4): 795–809.

[[9]] TIGARD D W. Artificial moral responsibility: how we can and cannot hold machines responsible[J]. Cambridge Quarterly of Healthcare Ethics, 2021, 30(3): 435-447.

[[10]] 丹尼尔•丹尼特. 自由的进化[M],曲娇译,北京:中信出版社,2022:120-121.

[[11]] ANDERSON M B. Moral luck as moral lack of control[J]. The Southern journal of Philosophy, 2019, 57(1): 5-29.

[[12]] NAGEL T. Mortal questions[M]. New York:Cambridge University Press, 2013: 35-36.

[[13]] KRKAČ K. Corporate social irresponsibility: humans vs artificial intelligence[J]. Social Responsibility Journal, 2019, 15(6): 786-802.

[[14]] WILSON A, STEFANIK C, SHANK D B. How do people judge the immorality of artificial intelligence versus humans committing moral wrongs in real-world situations?[J]. Computers in Human Behavior Reports, 2022, 8: 1-12.

[[15]] HONG J W, WANG Y, LANZ P. Why is artificial intelligence blamed more? analysis of faulting artificial intelligence for self-driving car accidents in experimental settings[J]. International Journal of Human–Computer Interaction, 2020, 36(18): 1768-1774.

[[16]] 休谟. 人性论[M],关文运译,郑之骧校,北京:商务印书馆,1996:446.

[[17]] 伍玉林,曲世闻. 威廉姆斯与内格尔的道德运气思想及其计算机伦理价值[J]. 自然辩证法研究,2013(11):103-106+57.

[[18]] SIO F S D, MECACCI G. Four responsibility gaps with artificial intelligence: why they matter and how to address them[J]. Philosophy&Technology, 2021, 34(4): 1057-1084.

[[19]] LEVY N. Putting the luck back into moral luck[J]. Midwest Studies In Philosophy, 2019, 43(1): 59-74.

[[20]] 康德. 道德形而上学奠基[M],杨云飞译,邓晓芒校,北京:人民出版社,2013:13.

[[21]] TIGARD D W. Responsible AI and moral responsibility: a common appreciation[J]. AI and Ethics, 2021, 1(2): 113-117.

[[22]] LEVY N. Dissolving the puzzle of resultant moral luck[J]. Review of Philosophy and Psychology, 2016, 7(1): 127–139.

[[23]] COECKELBERGH M. Artificial intelligence, responsibility attribution, and a relational justification of explainability[J]. Science and Engineering Ethics, 2020, 26(4): 2051-2068.

How to evaluate the moral luck of artificial intelligence?

LI Wei1, Li Xia2

(1. School of Marxism Studies, Shanghai University of Sport,Shanghai, 200438, China;

2. School of History and Culture of Science, Shanghai Jiao Tong University, Shanghai 200240, China)

【博主跋】这篇文章发在《科学技术哲学研究》2025(4),时间过得真快,转眼李伟博士后出站已经一年了,偶尔朋友们聚会时还是会聊起他,祝他在新的工作单位一切顺利,快乐地做自己的学术。

说明:文中图片来自网络,没有任何商业目的,仅供欣赏,特此致谢!

2025-8-3于南方临屏涂鸦!

转载本文请联系原作者获取授权,同时请注明本文来自李侠科学网博客。

链接地址:https://wap.sciencenet.cn/blog-829-1496347.html?mobile=1

收藏