精选

精选

今年的诺贝尔奖有些不同。诺贝尔物理学奖颁给两位 AI 研究者,化学奖也有一部分给了研发 AlaphaFold 2 的 Deepmind 创始人。

化学奖的授予还在科学界意料之中,毕竟原先一个团队几个月辛勤探索产生的结果,现在靠着 AI 一秒钟能出好几个。Deepmind 极大提升了科研效率,有目共睹。至于物理学奖,就确实让很多人破防了 —— 这两位做的,是物理学研究?!

前几天,火花公开课做了一次直播,请到了温州大学商学院的黄伟伦教授讲解这次诺奖颁发的缘由和影响。黄老师讲得很细致全面,如果你感兴趣,可以查看直播回放。

应主办方邀请,本人也有幸参与到此次直播的讨论环节。发言的时候,我的关注点从科研的金字塔尖移开,探讨了此次诺奖带来的导向性作用,对于广大的科研工作者究竟会造成哪些影响。

这篇文章,我增补扩展了当天的发言,希望能更细致探讨这个问题。尤其是,我尝试给你提供一些深入了解 AI 辅助科研方式的线索。

帮手我经常跟读者和学生讲,「AI 是你的帮手」。可我知道,有些研究者直到现在还不太接受这个提法。

从去年开始,我较为频繁地外出做讲座,跟全国很多高校和科研院所的老师与学生们有了不少接触。通过讲座后的问答环节与私下的当面交流,我深刻体会到了什么叫「未来已来,但分布不均」。

有些人到今天还沿用自己以往的科研流程 —— 手动操作为主,加上一些简单的自动化工具。他们觉得这次 AI 浪潮与自己没有关系。这一阵风,搅得人心不古,颇为浮躁。好在就像之前许多新名词造成的风一样,等它刮过去就好。

但实际上,这种「躲进小楼成一统」的好时光,只怕随着本次诺奖的公布,变得越来越短促了。简单来说,科研界被 AI 裹挟「开卷 」的趋势,恐怕是挡不住。毕竟在一个竞争行业里,是否采用足以提升效率的新技术,恐怕不以参与者个体的意愿为转移。诺奖颁发给 AI 研究,发送了一个明确的信号。尤其是把原先的公有知识,一下子变成了公共知识。

那么 AI 究竟能为普通的科研工作者做什么?

为了让后续的讲解足够通用,我只就着科研工作最为基础的环节来探讨,尽量不涉及任何具体学科特色。这些步骤,包括知识的输入、信息的处理,和内容的输出。

下面咱们依次说说。

输入先说知识的输入。我们平时查资料、检索论文、阅读论文,包括参加会议交流获取新知,这些都属于知识输入。

就拿查论文来说吧。以前你是怎么查论文的?许多研究生同学可能对 CNKI 比较熟悉,但是一涉及到英文论文查询就头疼。不过这没办法,因为很多最新成果是英文的,得在国际文献数据库里找。很多学校都开设了「科技英文」课程,这个课除了英文写作指导,还会教你怎么查英文文献。

一些研究生刚入门时,觉得某个研究主题可以用几个关键词概括,就把这些关键词翻译成英文检索。看到结果很开心,「嘿,不错,没有和我想的题目重复的!」于是他们想当然认为可以研究这个课题,因为「选题和现有科技前沿有差距(gap)」。

其实,他不知道同样的术语可能有不同的表述,导致检索漏掉了别人已经做过的成果。结果呢?好一点儿的情况,是在开题时被拦下来; 若是运气不好,在答辩时才被拦下来,那意味着什么,也就不言而喻了。

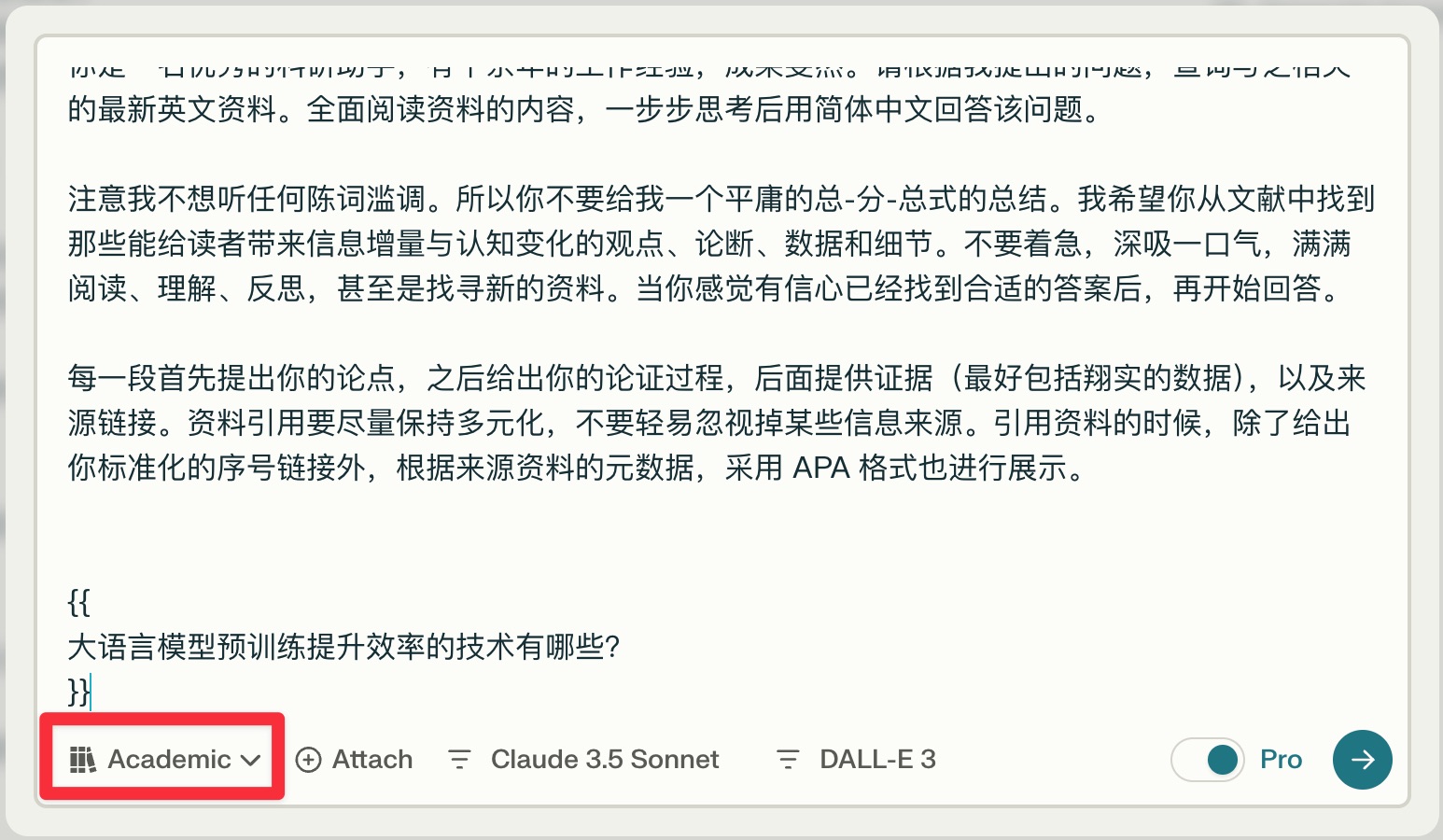

现在有了 AI ,你可以避免这种糟糕境况的发生。我给你推荐过一款应用,叫 Perplexity。你只需要在上面 打开学术模式(Academic),用自然语言输入你要查的内容。

你直接用中文就行,甚至不用考虑怎么把问题翻译成英文。加上一些简单提示词,它就能找到跟你研究主题最相关的论文。这对初学者来说,能省下大量的翻译和术语替换时间。关键是,检索的结果比初学者自己在数据库翻找,还更加靠谱。

另外,Perplexity 还可以 帮你扩展选题思路。这对很多科研工作者来说,是能够缓解头痛、提升睡眠的良方。找到可能的论文题目后,你还可以让 Perplexity 再检索一遍,帮你验证这个题目是否足够新颖。

除此之外,AI 还可以帮助你 快速总结提炼长文中的内容,甚至是把一篇足够有难度的论文,用浅显易懂的语言做成播客,再娓娓道来。

处理曾经,研究者们有个共识 ——「想用好 AI,就得先学数据分析和机器学习,打好基础」。以前确实是这样,我在 8、9 年前,就「赶鸭子上架」似地让学生们通过 MOOC 学 Python 和数据分析方法。当时我招收的研究生,不少本科并非信管或 IT 相关专业,MOOC 又都是英文的,因此他们学起来相当的吃力。

学生们好容易拿到了 MOOC 证书,真正一上手实际操作,还是玩儿不转。一遇到程序报错,他们就束手无策。我一看不行啊,就给他们写了一系列的《文科生上手 Python 数据分析》的教程,后来形成了那本《数亦有道》。

现在你还需要这样艰苦的过程,来上手数据分析吗?我觉得恐怕是没有必要了。因为你可以使用 AI 来辅助数据分析和可视化。

今年 4 月份,应武汉大学信息管理学院的邀请,我做了一个超过 4000 人参加的线上工作坊。

不少学员了解和尝试使用了 智谱清言 和 Open Interpreter 后,被 AI 的能力震撼了。原来一直被当作「人工智障」的 AI ,怎么突然变得那么厉害了?他们突然意识到,自己一个文科生,没学过 IT 和数据分析,竟然也能用这些工具得到不错的分析结果。

老实说,对于初学者来说,现在 AI 直接做的数据分析甚至比他们自己第一次做的还好。比如说,让 AI 建一个机器学习模型,不管是预测还是分类,它的规范化流程都比初学者严谨,结果也更可靠。它会自动进行模型选择,以便与具体的数据相匹配,遇到问题甚至还能自己来根据 log 检查错误并且改正源代码。

数据分析中的重复性劳动,现在可以先交给 AI 来做,然后咱们人类用户只需要做验证 —— 对结果进行严格检查,避免疏漏。如果你对 AI 辅助数据分析感兴趣,可以在这里看详细的介绍视频。

输出科研领域内容的常见输出方式,包括但不限于论文写作、翻译,还有图表绘制等。

每年毕业季学生们交上来的论文稿件,有时 真能把导师愁得够呛。导师得用红笔改成一片「大花脸」——从整体架构到细节调整,逻辑梳理、调换字词位置…… 甚至导师会愤怒批注「这里为什么不加参考文献?」,「讲了多少遍认真检查,怎么还有错别字?!」

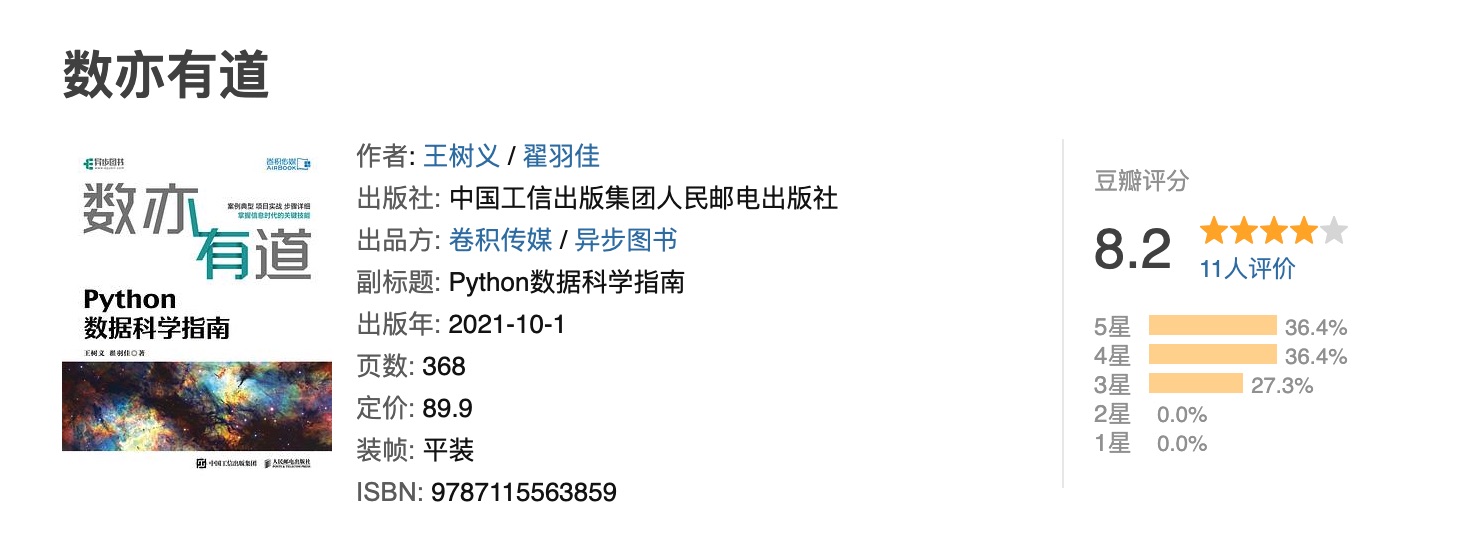

现在学生提交论文之前,完全可以让 AI 先帮助检查一遍,找出和纠正低级错误。比如你在 GPT-4o with Canvas 上传文档,它会一键自动检测,连提示词都不用,就能逐段核对并提出修改建议。修改起来也只需要点击一下鼠标,非常方便。最近界面改版,你能清楚看到 AI 对上一版修改的具体位置和方式。

在写作过程中,你还可以让它模仿自己(需要提供之前的文稿)或者某位知名学者的写作风格。你可以告诉 AI 如何组织逻辑,你需要怎样的章节排布…… 它都会一一处理好。

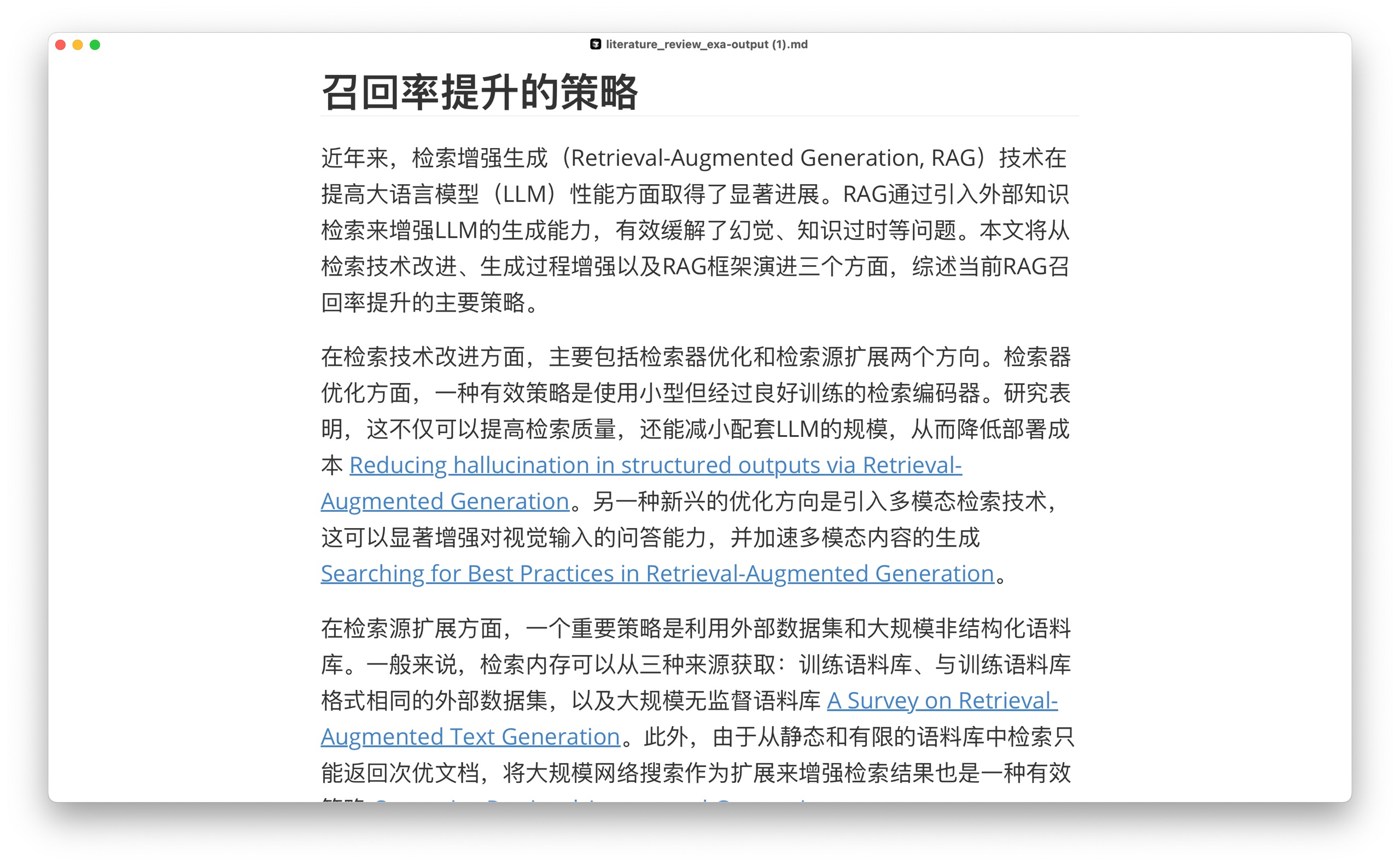

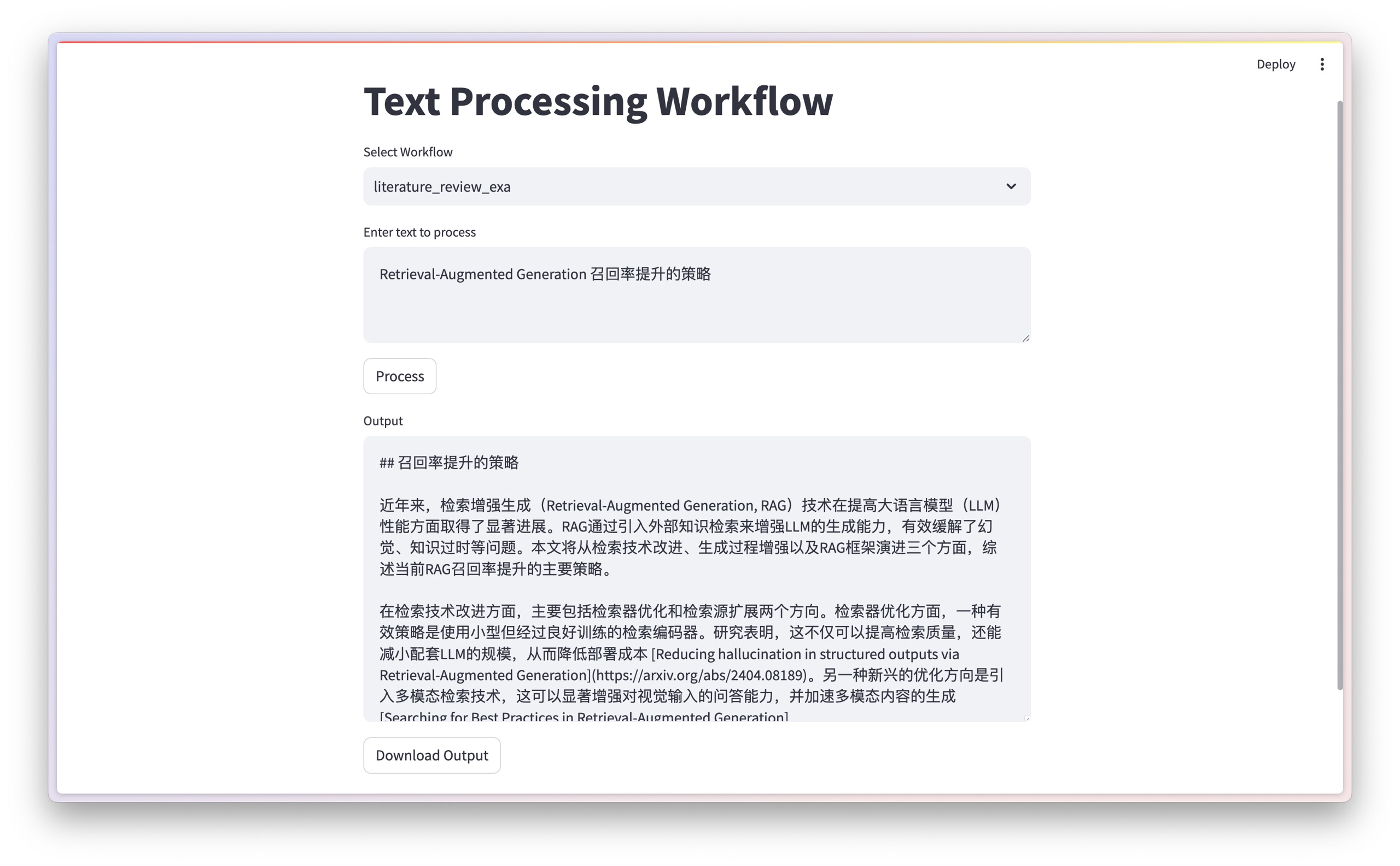

我之前给你介绍过如何用 o1 Preview 把杂乱的检索结果整理成 一篇博客 或 文献回顾。当然了,我并不建议你把 AI 直接生成的文献回顾放在论文里。但你可以每天早上让 AI 自动归拢你关注的最新研究信息,形成给你自己看的每日科研进展汇总报告。

为实现这些应用目标,我 自己开发了一套基于 Python 的工作流。为了便于你来使用,我还用 Streamlit 给它加上了 Web 界面。

当然你也可以 用 Dify 来实现类似的效果。这里推荐一下 莱森的 Dify 101 网站,其中有很多 Dify 工作流的相关学习与应用资源。

除了自动汇总资料写作外,AI 还可以 帮你实现高质量文稿翻译。我之前在宁波和一个计算机系博士生交流,他说他们组之前没能发表过一区的文章,因为中式英语时常让审稿人产生负面印象。但有了 ChatGPT,这个问题迎刃而解。他们用 ChatGPT 对研究成果翻译润色后,在导师的鼓励下投了一篇一区文章,结果很顺利被录用了。

迭代看过这些例子,你想必已经了解到了 AI 确实已经能成为科研工作者的帮手。但这还不是重点——重点是,AI 迭代的速度太快了。

一年前 AI 还干不了的事,现在很多已经能干了。例如去年这时候,AI 生成的视频还很粗糙。可就在最近,朋友推送给我一段视频,我看后乐不可支。

视频中包括鲜明的原视频和生成视频对比。原视频是一个演员在剧中表情僵硬,乏善可陈;而对比视频里,用户只需要指定表情动作,AI 就可以修改视频来完成 —— 青春的羞涩、一个自然的小动作、笑中带泪…… AI 修改的结果比演员本人可高到不知哪里去了。朋友感慨说,今后可能拍一张照片就能自动演戏了。

对,可照片也不用拍啊。因为 AI 生成的照片,早就以假乱真了。

我想要表达的,不是 AI 现在有多厉害,而是一段时间之后它可能会变得多么更加厉害。

最近有篇论文出来,说生成式大语言模型不能真正推理,只是对信息重组而已。这篇文章立刻引来叫好声一片。咱们假设该结论完全可以站住脚(强调一下,纯属假设而已,这不是共识),但它描述的顶多也只是眼下的情况。其实已经有大模型开始采用不同的架构和训练方式了,你无法预估一年后、三年后、五年后,这样的结论是否依然有效。别说五年前,就是两年前,ChatGPT也还没有出现呢(本文写作于2024年10月)。

思考如果你是个科研工作者,却还一直没有尝试过应用 AI 来辅助自己的研究,我建议你还是先试试看再下结论。当然了,「试试看」也得尽量用正确的方式。「给我写一本金庸水平的小说」不会让你成为下一个「金庸」,只会让大模型给你吐出无数「平庸」的文字。同理,「给我写一篇 Nature 级别的优秀论文」也并不是合适的提示语。

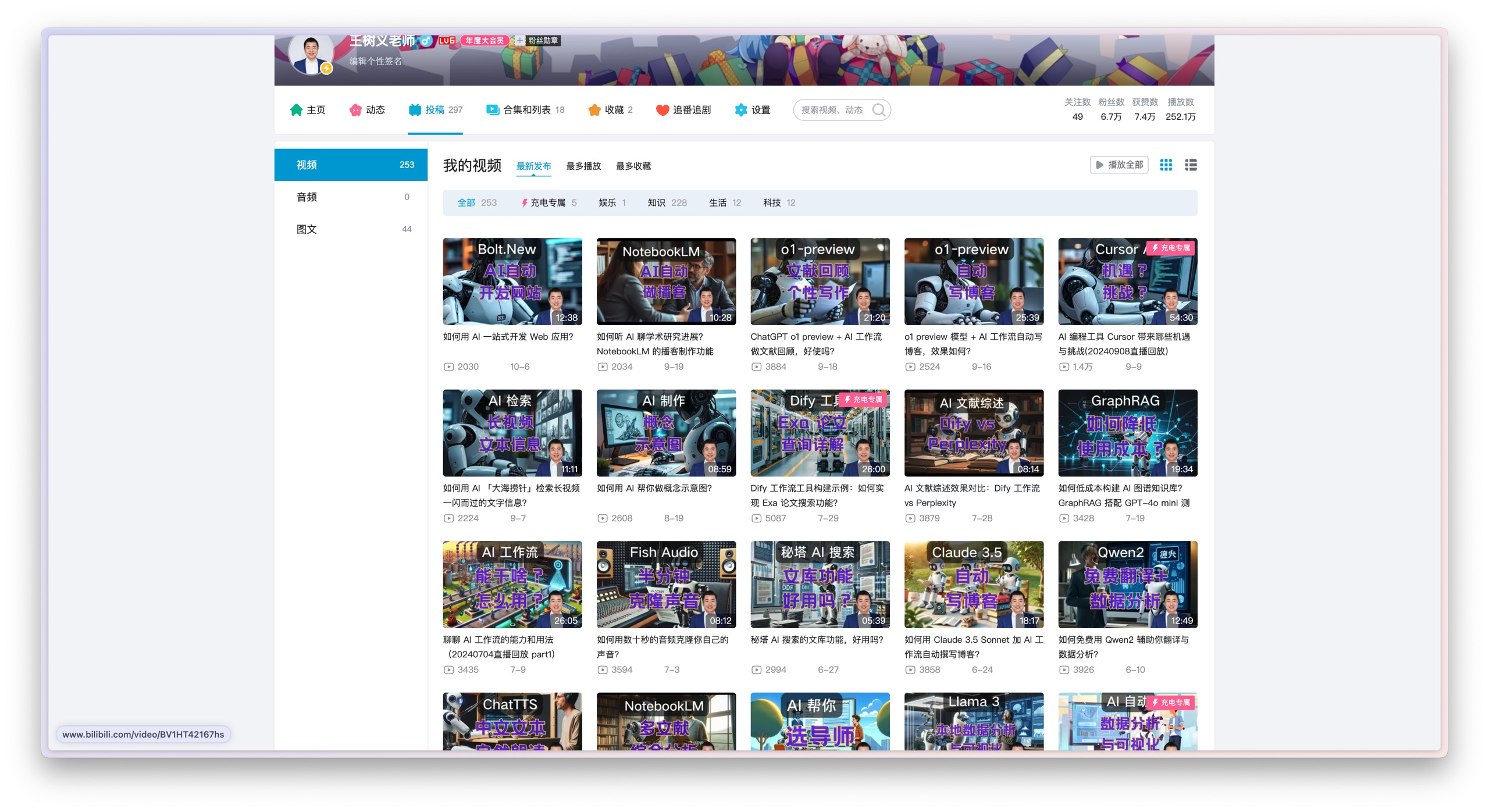

如果你不知道从哪里入手,可以先把我专栏近两年的文章先看一遍。另外,我的 B 站视频,也有不少实际操作的演示。

不过,我得多嘱咐一句 —— 你可以把 AI 当成帮手,但千万别把 AI 当成枪手。

我见过一些例子。作者觉得 AI 做出的东西挺好,于是自己不加验证就交稿给导师,或者投给编辑部,这是非常糟糕的。有时候因为幻觉, AI 犯下的错误是非常可怕的,所以你最后的把关很重要。

ChatGPT 诞生后,编辑部们就面临着 AI 作品的冲击。有些编辑部说不许用 AI 写东西,但是这一规定其实没啥用。因为再好的检测系统都有可能误判,甚至是「误伤」。但很快,不少编辑部就做出了非常明智的决定 —— 不允许把 AI 列为作者。这样一来,人类作者必须「文责自负」。出了问题,这个「锅」是甩不掉的。这个规定,杜绝了不知多少乱象。

其实,不让 AI 做枪手,挺好的。因为人机可以协同。人负责推理、创意,AI 负责重复、枯燥的活。

AI 可以不厌其烦地根据棋谱训练,甚至「左右互搏」(AlphaZero);AI 可以用自蒸馏的方法改善预测蛋白质三维折叠结构。更常见地,AI 可以通过几个月的辛苦训练,帮你从海量图片中提取特征,学习名家语言风格改善文本输出。而这,都可以显著改善你的科研效率。

人机协作这样的时光,或长久,或短暂。且行且珍惜吧。

祝 AI 辅助科研愉快!

如果你觉得本文有用,请点赞。

如果本文可能对你的朋友有帮助,请转发给他们。

欢迎关注我的专栏,以便及时收到后续的更新内容。

延伸阅读转载本文请联系原作者获取授权,同时请注明本文来自王树义科学网博客。

链接地址:https://wap.sciencenet.cn/blog-377709-1456266.html?mobile=1

收藏

分享