博文

基于子样本集构建的DCGANs训练方法

|

引用本文

陈泓佑, 和红杰, 陈帆, 朱翌明. 基于子样本集构建的DCGANs训练方法.自动化学报, 2021, 47(4): 913-923 doi: 10.16383/j.aas.c180677

Chen Hong-You, He Hong-Jie, Chen Fan, Zhu Yi-Ming. A training method of DCGANs based on subsample set construction. Acta Automatica Sinica, 2021, 47(4): 913-923 doi: 10.16383/j.aas.c180677

http://www.aas.net.cn/cn/article/doi/10.16383/j.aas.c180677

关键词

深度卷积生成式对抗网络,子样本集构建,深度学习,样本特征,联合概率密度

摘要

深度卷积生成式对抗网络(Deep convolutional generative adversarial networks, DCGANs) 是一种改进的生成式对抗网络, 尽管生成图像效果比传统GANs有较大提升, 但在训练方法上依然存在改进的空间. 本文提出了一种基于训练图像子样本集构建的DCGANs训练方法. 推导给出了DCGANs的生成样本、子样本与总体样本的统计分布关系, 结果表明子样本集分布越趋近于总体样本集, 则生成样本集也越接近总体样本集. 设计了基于样本一阶颜色矩和清晰度的特征空间的子样本集构建方法, 通过改进的按概率抽样方法使得构建的子样本集之间近似独立同分布并且趋近于总体样本集分布. 为验证本文方法效果, 利用卡通人脸图像和Cifar10图像集, 对比分析本文构建子样本集与随机选取样本的DCGANs训练方法以及其他训练策略实验结果. 结果表明, 在Batchsize约为2 000的条件下, 测试误差、KL距离、起始分数指标有所提高, 从而得到更好的生成图像.

文章导读

生成式对抗网络(Generative adversarial networks, GANs)[1]是2014年Goodfellow等依据零和博弈思想和纳什均衡原理提出的一种数据生成模型, 该模型[1-4]由生成器网络(Generative net)和判别器网络(Discriminative net)组成. 生成器G网络通过输入随机向量z使得输出值G(z)尽可能符合训练图像分布, 判别器D网络对输入的测试样本尽可能判别出测试样本的来源(即训练图像样本集或生成图像样本集). GANs的最终目的是通过充分训练, 使得G网络和D网络达到纳什均衡状态, 从而使得D网络难以判别出输入的采样样本的来源, G网络生成的样本分布逼近或相同于训练样本集分布.

GANs是一种经典有效的新型数据生成模型, 但为使得生成样本集分布与训练样本集分布相近或相同, 在模型的优化与训练上依然比较困难[1]. 主要原因在于G、D网络通常使用深度神经网络, 因此会体现出深度神经网络训练中的问题, 如难以训练、学习时间长、收敛较慢、训练最终效果难以控制等; 在优化器优化损失函数的时候可能出现梯度消失的问题[1-2], 从而导致G和D网络未达到训练要求前过早进入平稳状态, 使得训练失效; GANs在优化器优化损失函数时只会找低损失点, 不会找真正意义上的纳什均衡点[5], 可能导致对抗学习偏离纳什均衡点, 增大生成图像分布与训练图像分布的差距.

为使得GANs图像生成效果更好, 学者做出了一些改进工作, 通常改进的是网络结构、目标优化函数或网络的训练方式. Mirza等[6]提出一种CGANs模型, 它的损失函数带有条件约束, 在G网络和D网络之中引入条件变量, 从而将无监督GANs变成有监督GANs. Radford等[7]使用卷积神经网络(CNN)作为G网络和D网络, 提出了DCGANs (Deep convolutional generative adversarial networks)模型, 并且G网络和D网络中的CNN去掉了池化处理和全连接层使得GANs图像生成质量得以提高. Denton等[8]提出了一种金字塔LAPGANs模型, 其结合了CGANs和GANs的一些优点, 使用一系列的GANs来生成质量更高的自然图像. Odena[9]设计出SGANs, 使用半监督的方式使得G网络和D网络可以同时训练, 相互促进相互学习, 能够明显改变生成的图像质量和学习的时间代价. Donahue等[10]提出了一种双向结构的BiGANs, 增加了E网络(编码机)作为特征提取器, 用于将GANs要生成的数据空间中的数据逆映射回隐藏编码空间, 能够在实际场景中的自然图像达到好的效果. Zhang等[11]提出的StackGAN由两层CGANs组成, 可以生成非常真实的自然图像. Chen等[12]提出的InfoGAN中, G网络的输入信息z加入了隐含约束信息c, 能更好地解释z的语义信息, 也能得到内容更丰富的生成图像. Qi[13]和Arjovsky等[14]分别提出的LSGANs和WGANs主要是通过优化函数进行性能提升, 前者主要针对了G网络的过拟合问题, 后者主要针对了整个网络的梯度消失问题. Yu等[15]提出的SeqGANs通过改变网络结构和优化函数, 缓解了G网络输出值离散化后, D网络难以回传梯度对G网络进行参数更新的问题. 王功明等[16]在借鉴EBGANs的思想, 重新设计了一种能量重构误差损失函数, 在学习效率和图像生成质量上有所提高.

Salimans等[5]除将D网络损失函数改为半监督形式外, 也更改了它的训练方式, 对其使用MiniBatch的训练方法, 每次判别网络输入一批图像进行判别, 更改D网络损失函数正负样本概率权重, 在每次馈入的Batchsize个样本训练之前做Normalize处理. Do-Omri[17]将深度神经网络中的自训练(Self-training)过程融入到针对半监督任务GANs. Gulrajani等[18]使用梯度惩罚方法替代了D网络中权重剪枝的过程, 提高了WGANs的稳定性. Daskalakis等[19]针对WGANs中的极限循环问题, 使用OMD (Optimistic mirror decent)来改进训练WGANs. Mescheder等[20]使用D网络参数正则化策略稳定GANs的训练, 并且指出实例噪声(Instance noise)或零中心梯度惩罚的GANs训练上是收敛的.

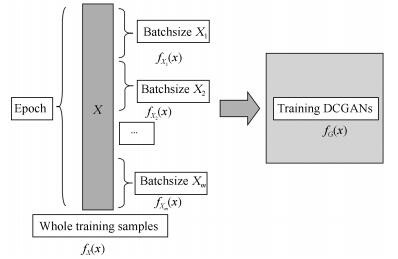

上述GANs相关文献从网络结构、优化函数、训练方式的改进使得GANs性能有所提升. 训练方式的改进主要对网络内部中间数据进行处理, 或网络中间层数据处理策略的改进. 本文通过对GANs外部数据(训练样本集)进行干预, 提出一种基于训练样本集特征分布的子样本集构建的训练方法. 先计算出整个训练样本集在选取的特征空间中的概率分布, 再对每次馈入(feed)生成器G的Batchsize个数据构建成与训练集分布差异更小的子样本集. 使得在每次epoch内, 每个Batchsize大小的子样本集分布均与训练样本集分布相似. 最后在卡通人脸数据集和Cifar10数据集上的实验结果表明, 相对于原有的训练方法, 本文能够取得更好的生成图像.

图 1 DCGANs训练示意图

为提高DCGANs训练的效果, 本文尝试通过对外部训练数据进行处理来影响最终的生成效果. 实验结果表明, 适当增加Batchsize大小, 对每次epoch馈入的子样本集经过人为构建能够影响生成结果, 与原有的训练方法比较, 提高了生成器网络生成的图像的效果, 这种处理方式能够减轻随机馈入数据对结果产生的不利影响. 同时也实践证明了在训练集概率统计分布过于抽象难以表达时, 其在特征空间中分布表达的有效性. 实验也证明了这几种训练策略的有效性, 它们可以相互替代. 当然本文方法也存在不足之处, 如由于加大了Batchsize大小, 导致了训练所需的时间更多. 训练之前需要对训练集进行较繁琐的预处理.

作者简介

陈泓佑

西南交通大学信息科学与技术学院博士研究生. 主要研究方向为机器学习, 图像处理. E-mail: chy2019@foxmail.com

陈帆

西南交通大学信息科学与技术学院副教授. 主要研究方向为多媒体安全, 计算机应用. E-mail: fchen@home.swjtu.edu.cn

朱翌明

西南交通大学信息科学与技术学院硕士研究生. 主要研究方向为深度学习, 图像处理. E-mail: swjtu163zym@163.com

和红杰

西南交通大学信息科学与技术学院教授. 主要研究方向为图像取证, 图像处理. 本文通信作者. E-mail: hjhe@home.swjtu.edu.cn

https://wap.sciencenet.cn/blog-3291369-1353678.html

上一篇:多视点稀疏测量的图像绘制方法

下一篇:基于局部补数-导数模式的光照反转和旋转不变纹理表达