博文

PCA

||

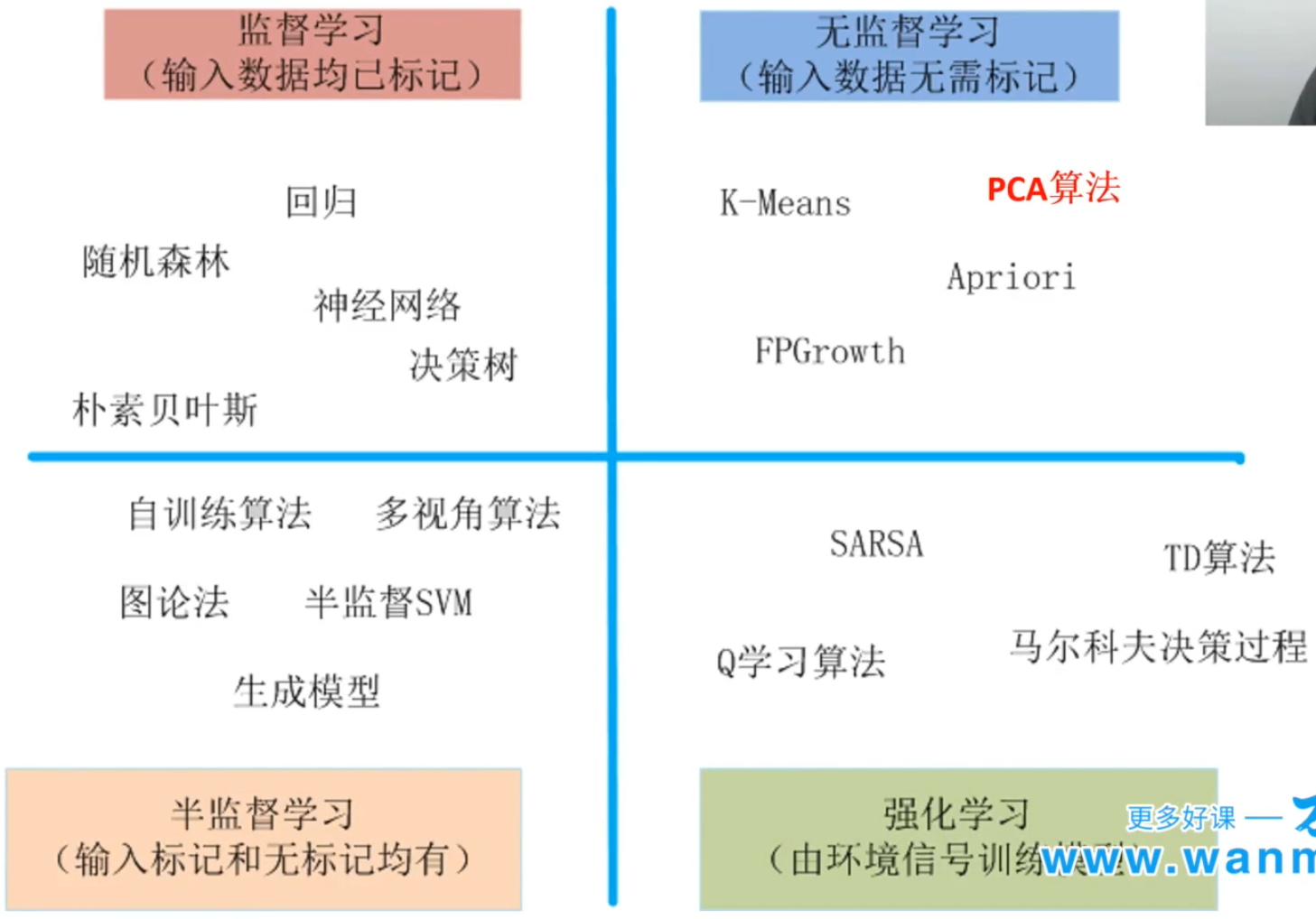

传统机器学习算法一览

无监督学习主要有降维算法和聚类算法。

-Dimension Reduction->

-Dimension Reduction->

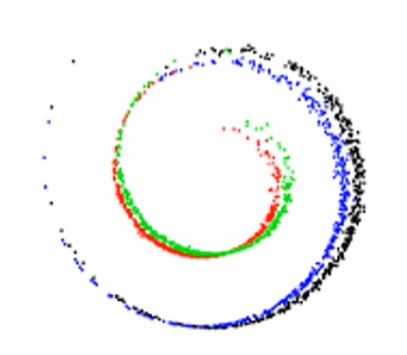

选择正确的数据特征表示方法是重要的,有利于发现数据潜在规律。

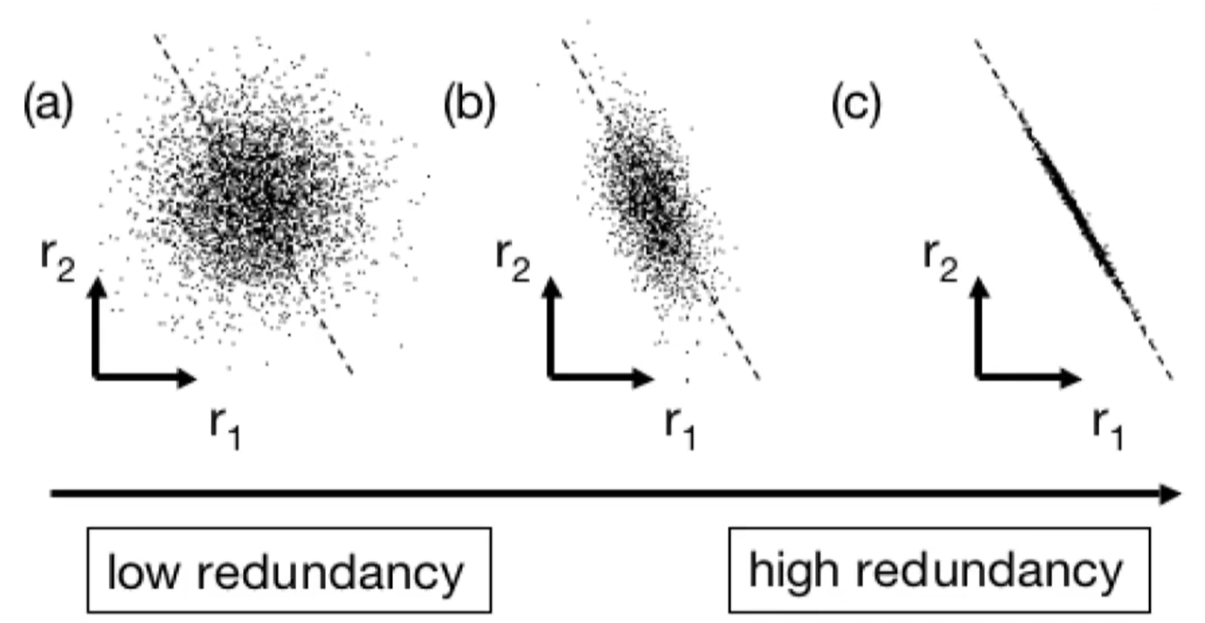

什么是PCA?PCA-其名称 principle component analysis就是一种能够从高维度数据里提取信息的方法。PCA让我们假设数据的特征分布符合高斯分布,但是特征不是独立的,而是存在大量线性相关的特征,线性相关的特征使得数据冗余,并且加深维度灾难,使得训练缓慢。如何减少这些冗余的信息,找到一个更好的对数据的表示法?这时候,我们找到基于无监督学习的方法PCA。

PCA理解:

PCA背后的假设:

1)Linearity(线性关系);2)Gaussian(特征符合高斯分布);3)Lower variance component is noise(低方差成分是噪声)。

PCA的本质:

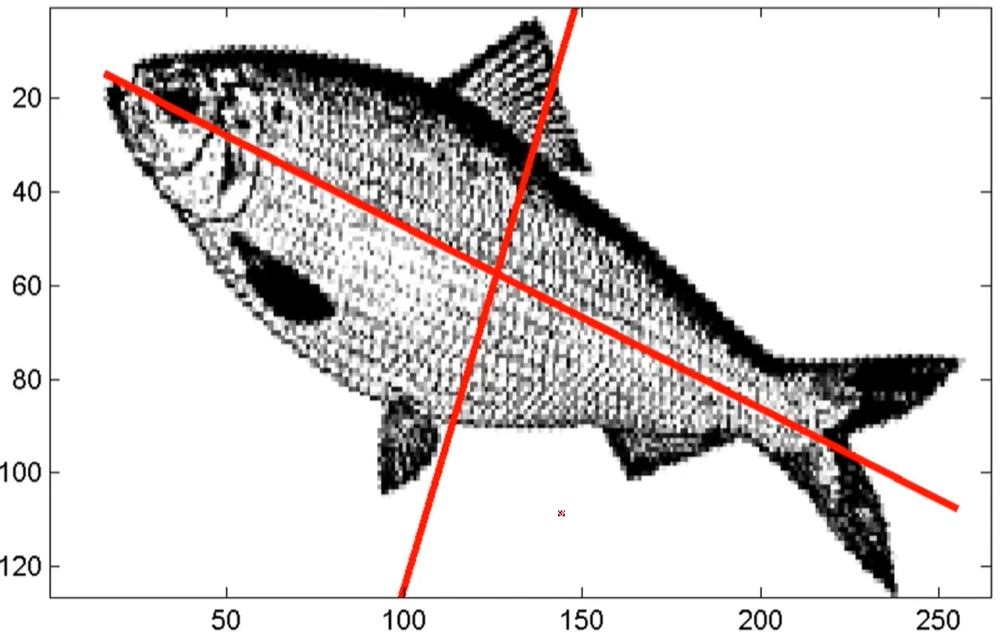

PCA的本质是对特征(向量)的坐标变换,通过把线性相关的特征合成一个,重新合成一组正交的特征。我们知道,要显示两个不同的特征是否线性相关的做法一般是求解其协方差,如果我们所有特征的两两相关系数放到一个矩阵里,这个时候得到一个矩阵叫协方差矩阵,这是对数据内部的相关性最好的表示。

在线性代数里,这个矩阵对应的特征向量,就是那组基,它代表了不同特征的组合所形成的新的特征,而新特征两两正交。而线性代数告诉我们,这时候形成的新特征具有最大特征值的那一个,恰恰是聚集了数据中最多的方差,也就是集中了数据中最多的变化,这样的方向即主成分方向。以此类推,我们可以得到第二,第三主成分。

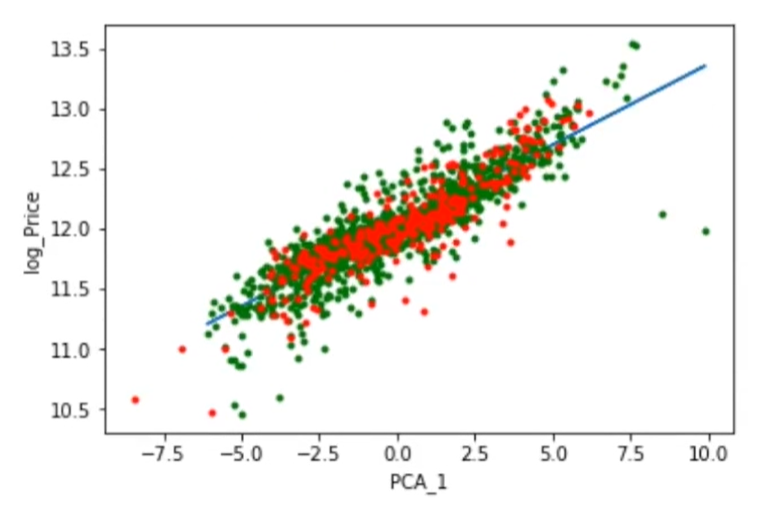

PCA降维效果:

第一分量和目标的相关性(散点图),高度相关。与原先结果(r2=0.87)做比较,结果也不差很多,但是需要数据量减少很多(仅一个维度),因此PCA给出的结果还是很划算的。

点滴分享,福泽你我!Add oil!

https://wap.sciencenet.cn/blog-3428464-1231700.html

上一篇:集群模型

下一篇:神经网络(升维大法)

全部作者的其他最新博文

- • [转载]太阳同步轨道

- • 膳食指南