博文

基于逐像素点深度卷积网络分割模型的上皮和间质组织分割

|

引用本文

骆小飞, 徐军, 陈佳梅. 基于逐像素点深度卷积网络分割模型的上皮和间质组织分割. 自动化学报, 2017, 43(11): 2003-2013. doi: 10.16383/j.aas.2017.c160464

LUO Xiao-Fei, XU Jun, CHEN Jia-Mei. A Deep Convolutional Network for Pixel-wise Segmentation on Epithelial and Stromal Tissues in Histologic Images. ACTA AUTOMATICA SINICA, 2017, 43(11): 2003-2013. doi: 10.16383/j.aas.2017.c160464

http://www.aas.net.cn/cn/article/doi/10.16383/j.aas.2017.c160464

关键词

深度卷积网络,乳腺组织病理图像,上皮和间质组织分割,逐像素分割

摘要

上皮和间质组织是乳腺组织病理图像中最基本的两种组织,约80%的乳腺肿瘤起源于乳腺上皮组织.为了构建基于乳腺组织病理图像分析的计算机辅助诊断系统和分析肿瘤微环境,上皮和间质组织的自动分割是重要的前提条件.本文构建一种基于逐像素点深度卷积网络(CN-PI)模型的上皮和间质组织的自动分割方法.1)以病理医生标注的两类区域边界附近具有类信息为标签的像素点为中心,构建包含该像素点上下文信息的正方形图像块的训练集.2)以每个正方形图像块包含的像素的彩色灰度值作为特征,以这些图像块中心像素类信息为标签训练CN模型.在测试阶段,在待分割的组织病理图像上逐像素点地取包含每个中心像素点上下文信息的正方形图像块,并输入到预先训练好的CN网络模型,以预测该图像块中心像素点的类信息.3)以每个图像块中心像素为基础,逐像素地遍历图像中的每一个像素,将预测结果作为该图像块中心像素点类信息的预测标签,实现对整幅图像的逐像素分割.实验表明,本文提出的CN-PI模型的性能比基于图像块分割的CN网络(CN-PA)模型表现出了更优越的性能.

文章导读

根据美国癌症协会[1]和我国抗癌协会[2]的最新统计, 乳腺癌是女性最常见的恶性肿瘤, 发病率居女性恶性肿瘤之首.在多数情况下, 乳腺癌的发病原因是因为受到多种致癌因子的刺激, 从而引起乳腺上皮细胞发生基因突变, 病理表现为无限增殖的癌细胞具有不同于正常上皮细胞的异型性, 并导致显著的组织异型性.组织病理图像分析是乳腺癌诊断的“金标准”[3].上皮和间质是乳腺组织病理图像中两种最基本的组织.上皮组织是一种细胞组织, 通常存在于导管和小叶系统中.间质组织包括包围在导管和小叶、血管, 以及淋巴管周围的脂肪和纤维结缔组织, 是这些组织结构的支持框架.约有80%的乳腺肿瘤起源于乳腺上皮组织.癌症的增长和发展通常依赖于间质和上皮组织的微环境[4].因此, 上皮和间质的组织的自动分割是分析乳腺肿瘤微环境[5], 构建癌症的计算机辅助诊断系统的前提[6].

然而, 组织病理图像具有高度的复杂性, 在组织病理图像中自动分割上皮和间质组织具有如下难度:

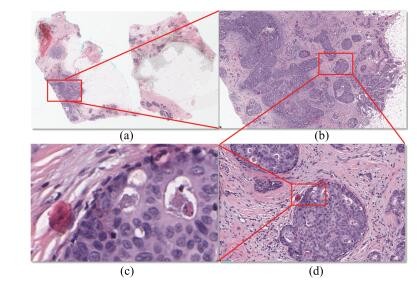

1) 高分辨率组织病理图像尺寸大, 是名副其实的“大数据”. 图 1(a)~1(d)分别展示了某患者一张全扫描组织病理切片在显微镜不同扫描分辨率下的图像.其中图 1(a)是1 : 0放大倍数下全扫描组织病理图像, 其尺寸约为100 000像素×700 000像素, 压缩后的存储空间约为1.43 GB. 图 1(b)是图 1(a)中红色区域放大4倍数后的图像; 图 1(c)是图 1(b)中红色区域放大20倍数后的图像; 图 1(d)是图 1(c)中红色区域放大40倍数后的图像.在这种高分辨率、大尺寸图像中运用计算机自动分割两类组织, 对硬件和图像分析算法都有较大的挑战.

图 1 显微镜不同物镜放大倍数下的乳腺肿瘤组织病理图像

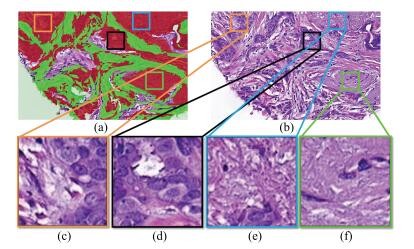

2) 组织病理结构类型复杂, 上皮和间质组织相互交织在一起, 相互之间没有明确的界限.同一类组织的形态差异很大.一张组织病理切片拥有众多的病理结构类型, 形态各异, 如图 2所示.图 2(a)用伪彩色标记病理医生的人工标注, 其中红色和绿色分别代表上皮和间质区域, 未被染色的区域是目前不被关注的区域即背景区域; 图 2(b)是包含上皮和间质组织的原始的乳腺H和E染色组织病理图像. 图 2(c)~2(f)是根据病理医生标记位置, 随机从图 2(b)中的上皮组织区域(红色区域)取出的图像块.通过比较这些图像, 可以看出上皮组织的组织结构、形态等, 差异性非常大, 组织难以用固定的特征来描述.因此, 目前传统的计算机图像分析方法难以分割这些组织.

图 2 上皮组织的不同形态

3) 具有不同组织病理学分级的组织病理图像组织异质性大, 其中在病理学分级越高(恶性程度越高)的组织病理图像中, 上皮和间质组织的自动分割难度越大. 图 3(a)~3(c)中是组织病理学分级为1的患者中选取的切片, 图 3(d)~3(f)中是组织病理学分级为2的患者中选取的切片, 图 3(g)~3(i)是组织病理学分级为3的患者中取出的切片, 图 3(c)、3 (f)和3(i)是病理医生做的人工标注.根据病理医生的标注(图 3(c), 3(f), 3(i))中得到的边界信息, 从原始H & E图像(图 3(a), 3(d), 3(g))中的上皮和间质组织交界处随机选取一些小块放大后的图像块如图 3(b)、图 3(e)和图 3(h)所示.可以很明显地看出, 组织学分级越高的图像中上皮和间质组织形态和结构越混乱, 上皮和间质组织之间的边界越模糊, 视觉上的差异也越不明显.这些问题给上皮和间质组织的自动分割算法带来更大的难度.

图 3 不同组织病理学分级的图像

4) H & E图像不仅背景复杂、噪声大, 而且存在染色不均、染色批次效应等问题.此外不同扫描仪成像质量存在差异.这些方面都会对自动图像处理分析算法带来难度.

尽管存在上述难度, 仍有不少学者在组织病理图像的上皮和间质组织自动分割中做出了优秀的研究成果, 推动了这个领域研究的发展. Linder等[7]提出了一种基于局部区域二值化(Local binary patterns, LBP)[8]为基础的方法, 用80×8080×80的滑动窗口从图像中提取出重叠的小块并提取小块的纹理特征, 最后基于该纹理特征使用支持向量机(Support vector machine, SVM)[9]分类, 从而自动分割免疫组织化(Immunohistochemistry, IHC)[10]染色的微阵列组织(Tissue micro arrays, TMAs)中的上皮和间质组织. Beck等在文献[11]中提出了著名的C-Path模型, 能够基于乳腺组织病理图像分析自动地预测患者的5年生存期, 引起了学术界和工业界的极大关注[12].为了构建患者的5年生存期预测模型, 作者运用了超像素过分割的方法[13]将组织病理图像首先过分割成多个小区域, 然后基于这些小区域进一步分割每个小块中的细胞核以及细胞质.受这个工作的启发, Ali等在文献[14]中使用超像素过分割的方法从病理图像中提取小区域并用于SVM的训练, 并运用于分割口腔咽鳞癌图像中上皮和间质组织. Hiary等在文献[15]提出了贝叶斯表决模型用于分割上皮和间质组织. Eramian等[16]用二值图像分割的方法分割牙源性囊肿图像中的上皮和间质组织. Amaral等[17]使用基于可视化的字典学习的方法来自动区分由IHC染色的TMAs中的上皮和间质组织.文献[18]中首先运用多尺度超像素分割上皮组织, 然后结合图聚类的方法自动检测全扫描图像中的导管原位癌区域.

与以上提到的传统的图像分析方法不同, 深度学习在基于大量训练数据的基础上, 运用数据驱动的方式通过组合底层特征构建更加抽象的高层特征.以深度卷积网络(Convolutional networks, CN)为代表的深度学习模型表现出了强大的鲁棒性和普适性, 在自然场景中的图像分类和检测中取得了巨大成功.随着该领域研究的深入, 研究人员的研究目标开始从简单的图像分类转变为复杂的大尺寸图像的逐像素分割.而组织病理学图像具有的高度复杂性正好符合这样一个应用目标.与分类和检测的任务不同, 对整张图像的自动分割具有更大的难度.尤其是对组织病理图像中不同组织结构的自动分割具有更大的难度.近年来, 深度学习方法开始被广泛运用于组织病理图像分析.该领域的先驱工作是Cirećsan等在文献[19]中, 成功地运用深度卷积网络在乳腺组织图像中自动检测正在进行有丝分裂细胞.作者使用具有卷积层和池化层的深度神经网络[20-21]来学习图像的高层特征, 然后使用softmax分类器对每个像素点进行分类, 从而实现细胞有丝分裂检测的目标.这项工作赢得了ICPR 2012和MICCAI 2013细胞有丝分裂检测大赛的冠军. Cruz-Roa等在文献[22]提出了一种卷积编码器的自动神经网络架构, 将深度卷积神经网络与自动编码器[23]结合在一起用于组织病理图像中导管原位癌区域的自动检测. Xu等在文献[24]运用堆叠式稀疏自动编码器框架对乳腺病理组织学图像中的细胞自动检测. Wang等在文献[25]提出将手动特征和CN学习到的高层特征组合检测细胞有丝分裂. Xu等在文献[6]中首先运用超像素分割方法把上皮和间质组织过分割为小块区域, 然后把该小块区域输入到训练好的CN模型以预测该整个图像块的组织类型.

本文内容分配如下, 第1节介绍本文使用的深度卷积神经网络结构; 第2节介绍了图像预处理方法; 第3节介绍了训练集的构建方法; 第4节介绍本文的实验流程; 第5节是本文的实验结果及其讨论; 第6节是对本文工作的总结和展望. 表 1列出了本文所使用的缩写符号及其解释.

本文提出了一种基于深度卷积网络的逐像素点分割(CN-PI)模型, 分割乳腺组织病理图像中上皮和间质组织.将CN-PI与其他基于图像块分割的深度卷积网络(CN-PA)模型在分割两种组织的性能上做了对比, CN-PI模型在分割准确率上具有较明显的优势.

不过, CN-PI模型在分割的过程中, 由于以待分割图像的每个像素点为中心像素构造的图像块都需要输入到CN中进行预测, 因此如果图像尺寸特别大, 将需要耗费较长时间.该不足还有待在未来的模型中加以改进.未来的工作拟将间质和上皮分割的结果运用于肿瘤的恶性程度的自动评分, 从而实现基于组织病理图像计算的肿瘤恶性程度自动评分的目标.

作者简介

骆小飞

2013年和2016年在南京信息工程大学获得学士和硕士学位.主要研究方向为机器学习, 计算机视觉, 医学图像分析.E-mail:luoxiaofeifly@163.com

陈佳梅

武汉大学中南医院博士研究生.2012年获得武汉大学学士学位.主要研究方向为基于计算机图像和分子探针影像分析的乳腺癌生物学行为研究.E-mail:cjm7352@163.com

徐军

南京信息工程大学教授.主要研究方向为计算病理学, 数字病理, 癌症的计算机辅助检测、诊断与预后, 基于深度学习及大数据驱动的医学数据分析, 临床转化医学.本文通信作者.E-mail:jxu@nuist.edu.cn

https://wap.sciencenet.cn/blog-3291369-1433211.html

上一篇:一类采用分数阶PIλ控制器的分数阶系统可镇定性判定准则

下一篇:《自动化学报》2023年50卷4期目录分享