博文

人脸识别技术是一种新的颅相学吗?

|

人脸识别技术是一种新的颅相学吗?

李侠 霍佳鑫

(上海交通大学 科学史与科学文化研究院)

2019年5月14日,美国旧金山市通过立法以绝对优势通过禁止使用人脸识别技术,从而成为美国第一个禁止该技术滥用的城市,估计也是全世界第一个。反观当下,国内人脸识别技术从研究到应用搞得如火如荼,正在快速向各个领域扩散,如何看待技术过度使用这个话题已经成为当下亟需认真思考与反思的紧迫公共议题。

一、技术带来的透明化与人类的福祉的核算

按照学界的共识,所谓的人脸识别原本属于计算机视觉研究范畴,对于人脸识别而言,特指计算机利用分析比较人脸视觉特征信息自动进行身份鉴别的智能技术(景晨凯、庄雷,2018)。它的发展大体经历了三个阶段,第一阶段20世纪60年代,第二个阶段20世纪90年代,第三个阶段,新世纪以来。随着深度学习的快速发展,以及大数据的运用,暴力计算的流行(目前人工智能领域的主导范式之一),人脸识别的研究出现了井喷式的发展。不论你喜欢与否,我们正在遭遇一种新的生存环境,在此有必要分析一下新技术带来的风险类型问题,并在此基础上寻找解决之策。

任何技术由于其未来发展的不确定性,可以对其可能引发的风险进行简单分类,根据后果的不同,大体上可以把技术引发的风险划分为四类,根据美国政策专家贾萨诺夫的划分方法,我们可以得到如下四个风险象限,见下图:

根据上图的划分,人脸识别技术属于哪类风险呢?先从发生概率角度来看,人脸识别技术的滥用显然属于高概率事件,因为有无数机构想要用到这些技术,它所提供的信息与数据具有多重价值,不论是经济原因还是其他原因,这种需求都是巨大的,再加上我国相关立法的严重滞后与执行中存在的问题,由此决定了人脸识别技术的扩散属于高概率事件;那么这种技术的风险程度如何?这是一个比较难以归类的问题,对于个人而言,人脸识别技术造成的最大危害在于个人隐私的泄露,仅就这一点而言,个人隐私的价值还是较小的,但是,由于整个社会是由无数个人组成的,换言之,人脸识别技术对于整个社会造成的风险却是巨大的,可以用公式简单表达如下,社会总风险=Σ个人风险的总和,也许更为可怕的是,人脸识别技术会造成整个社会治理模式的完全改变,使整个社会处于有选择的透明化,对于个人而言,他的自由与权利都将受到严重侵蚀。这绝非危言耸听,想想奥威尔在《1984》里所预言的全面监控社会,不难理解这种局面绝非臆想,如今日趋完善的技术已经完全有可能做到这一点。可以设想一下,如果“天眼工程+人脸识别”会带来什么结果,笔者曾开玩笑说:互联网时代历史悠久的小偷行业已经终结。综合上述两点,我们可以把人脸识别技术定性为:高概率高风险技术,按照美国经济学家米歇尔·渥克的说法:这就是一种典型的灰犀牛现象。由于个体认知的局限性,当今社会最容易出现的误判就是把人脸识别技术当成“高概率低风险”类型,造成这种错误的原因在于个体仅从个人收益受损的角度来推断该技术给整个社会带来的风险,是典型的以偏概全认知模式。温水煮青蛙现象的后果就是一开始的绥靖选择,必然导致结果的无法逆转。

作为反思的前提,在推行任何一项技术时应该采取的伦理原则是什么?由于我们通常并不能准确地预知我们行动的后果会是什么,尤其是考虑到在技术的前端与中端还处于严格的技术领域范围内时,黑箱结构带来的后果更是无从预期,为了降低风险采取分布式道德是合理的,即每一环节都负载道德责任。对于社会而言,这时所能做的就只有从开端与终端处对技术进行伦理约束,前者就是哲学家们热衷的道义论,即决定去做一件事,这种决定在动机上是否是善的,这种考虑固然有其价值,能够对某一些行动者起到预先的警示作用,但是作用微弱,大多受众被排除在技术之外。基于这种考虑,从终端处开始对技术进行伦理评价就能把潜在受众最大限度上包括进来,从而增加伦理的约束力。针对技术分布链条的不同阶段进行规制,划分有效责任区间恰恰是对技术进行伦理约束的常规做法。这也是技术扩散时遭遇到的一个具有普遍性的问题,对于作为技术受众的我们而言,可以采用后果论的处理方式约束技术,按照哲学家德里克·帕菲特的说法:“最好的结果是那个带给人们的收益减去负担后的最大净利益总量的结果,或者按照这个主张的快乐主义版本来说,是那个带给人们减去悲惨之后最大净幸福总量的结果。”那么人脸识别技术的成本收益情况如何呢?

像人脸识别这样的技术其使用是有很高门槛的,换言之,只有政府、准政府与大型商业机构才有可能被允许使用,由此可知,这项技术应用的最大潜在收益也将由这些机构获得,只有少部分溢出会被消费者分享,比如大型公共机构、机场、火车站等由于使用人脸识别技术会导致安全性的提升,这少部分流向消费者的溢出收益会被当做推行该技术的合理借口,而大部分收益则会被使用者完全独享;相反人脸识别技术带来的风险与成本却要全体消费者分担,比如个人隐私的大范围泄露等。从这个意义上说,在人脸识别技术扩散的所有领域中,机构与个体消费者在权利与收益方面处于完全不对等的情形,前者是积极的推动者,后者的自我保护能力有限。

人脸识别技术带给个体的最大变化就是人的透明化。透明化会让人的自由和权利被侵蚀或者损害,技术所及之处私人领域被彻底摧毁,而自由与权利大多寄居于私人领域,这已是技术发展的普遍现象。我们不妨就人脸识别技术可能出现的负面后果做一些简单扫描不难明白这个道理。从经济层面来说,假如技术进一步发展,人脸识别技术与医院的大数据相结合,通过对一些特定参数的设定,人脸识别技术完全有可能比较准确地判定一个人是否健康、或者是否有什么疾病。毕竟医院对于某类疾病拥有丰富的大数据,这些数据包含该疾病的一些共性特征,那么通过人脸识别技术,这些个体的信息对于某些机构来说就成为剥夺消费者的利器,比如保险公司,它借助于人脸识别技术最大限度上降低了信息不对称现象,通过拒绝对某类人群投保或者提高保费,从而实现一本万利的生意。问题是保险的出现就是人类为了应对未来的不确定性与风险所设计出来的一种防范措施,但是技术可以使商家最大限度上消除这些不确定性,如此一来,个体的投保行为就没有了任何意义,因为不确定性发生了转移,从商家彻底回归到消费者身上。人脸识别技术并没有给消费者带来预期的收益,反而是损失最大化。在技术进步面前,任何个体都是渺小的。

遗憾的是在新技术进步层面,人类陷入了囚徒困境:没有最优解,只有次优解,没有任何国家会放弃这项研究,否则就会出现严重利益受损,只有通过加速这项技术的进步才能在竞争中不至于被对方占便宜,一旦进入囚徒困境,就会加快技术进步的脚步,这样一来,作为个体的人就会成为最大的受害者,而由此带来的利益却被机构分享。

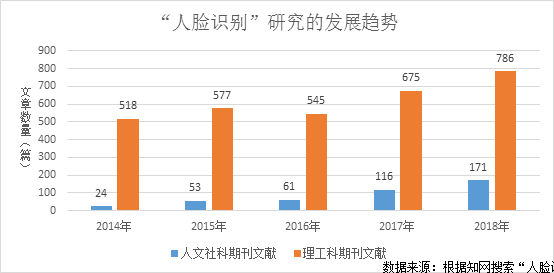

在道德方面,人脸识别技术也会带来一些难以处理的困境,比如研究机构可以对所谓的聪明人进行数据收集,然后用这些数据去衡量和评价人才,这同样是很可怕的事情。至于“以貌取人”更是成为一种无法根除的认知偏见。再比如对人类微表情、性格特征了解的深入,以及算法的进步,人脸识别技术甚至有可能发现个体的性取向(如同性恋等),这又是属于高度隐私的问题,这些信息一旦被泄露或被利用会带来很多麻烦的伦理问题。从上述这些案例中,可以清晰感觉到人脸识别技术有着广泛的市场需求,市场上一旦有需求将极大地推动技术的进步,下面可以通过一些数据来佐证我们的担忧。

从上图中可以直观发现近五年来,人脸识别研究呈现出快速升温迹象,不论是纯粹技术领域还是人文社科领域这种升温趋势都非常明显,短短五年时间,人文社科领域关于人脸识别技术的文献增长了6倍,但是从总体来看,人文社科的研究仍然远远落后于技术领域的发展。从这个意义上说,加强人文社科领域的研究并没有制约技术的发展,反而是严重滞后了,对于以人脸识别技术为代表的高科技发展,必须辅以伦理约束已经成为共识,虽然人文社科的约束力比较弱,但是至少会起到一种潜在的有益影响,如果连这一环节都省略了,那么技术的自主发展将是一条充满未知的旅途。论文仅仅从一个侧面反映了研究现状,而专利则表明技术在快速向市场领域扩散,据学者们研究在过去的27年间(1990-2016),通过检索发现全球在人脸识别技术领域颁布了15 592个专利族,其中排名前四的国家分别是:中国(5322件,本数据不包括港澳台地区)、日本(3810件)、美国(3113件)、韩国(1844件),这四个国家共占相关专利的90%以上(章帆等,2018)。暂且不论专利的质量与水平高低,中国的机构与企业对于该项技术表现出强烈的热情,由此衍生出的扩散速度也是极为惊人的。现在有越来越多的机构开始使用人脸识别技术,甚至笔者所在的高校图书馆都已经开始刷脸了,笔者一直怀疑真的有这种必要吗?还不知道社会上有多少商家和机构正跃跃欲试准备使用这项技术。

二、颅相学的教训与人脸识别的未来

刷脸时代的到来,不禁让人想到200年前在欧洲流行甚广的颅相学(Phrenology),它是由德国神经解剖学家加尔(F.J.Gall,1758-1828)在18世纪末创立的,他认为脑的某些区域与特定功能有关,如智力或性格等,而这些功能的强度可以通过颅骨的形状表现出来。据学者余佳总结,加尔的颅相学主要包括如下一些内容:1大脑组织是支配人的品性和行为的器官;2、特定部位的大脑组织决定特定的品性和行为;3、大脑组织与其表面的头骨形状有关系,头骨隆起和下榻,则其内部相对应的脑组织也会随之丰满或单薄;4、脑组织形状的变化会影响其功能。这些内容有些符合科学事实,而有些则是基于相术的无根据联想,导致一般人很难真正分辨出哪些是可取的观点,哪些是错误的观点。公众对于这种拼盘理论更是各取所需,从而导致颅相学在十九世纪的欧洲和北美很有市场,一些著名学者也参与其中,比如发现大脑语言区的法国医生布洛卡就是狂热的颅相学信奉者。客观地说,颅相学本是科学与相术的混合体,加之加尔本人就是一名科学家(神经解剖学家),这使他的这种混合体理论很有迷惑性。这种现象也是科学史上的经典现象:科学的杂化过程。杂化过程往往需要很多年才能得到有效的清理,即便如此,也无法完全清除其影响,因为即便是错误的理论也是会有人相信的。时至今日,颅相学仍有市场。当下的人脸识别技术与200年前的颅相学也有很多相似之处。随着算法与深度学习的推进,个人信息的传输、交流、转换、分配、扩散、利用等环节都是个人无法掌控的,在这种背景下,个体的透明化已是大势所趋,这个时候必然带来彼得·休伯(Peter Huber)所谓的“个人风险”与“公共风险”的不对称性增加。

既然人脸识别技术的潘多拉盒子已经打开,那么幻想关上大门的想法就显得过于天真。在一个透明化时代,如何最大限度上捍卫个体的自由和权利就是我们每个人的责任。白俄罗斯评论家莫罗佐夫曾说:有些技术需要公开和透明的伦理,有些技术需要保密和藏匿的道德。对此,我是深以为然的。对于人脸识别技术而言,它的应用需要的是公开和透明。由于它涉及无数人的利益与福祉,那么基于后果引入社会评价就是合理的。为了实现这个目标,做为受众的我们需要在认知上理解风险折现的理念,否则全民参与就是一句空话。

哈佛大学凯斯·桑斯坦教授曾指出:对于从现在起数个世纪后才会被感受到其影响的规制而言,任何合理的折扣率都将会使看起来巨大的收益变得接近于零。遥远未来的最差情形就可能看起来一点都不差。桑斯坦教授还是过于乐观了,对于气候变化这类长时段的事件来说,他的说法可能是对的,但是对于新技术的应用而言,其生命周期要短得多,这种折现效果很快就会体现出来。我们之所以忽略或者低估不太遥远未来的风险,是因为未来风险折现到当下的损失是很小的,从而造成群体性不敏感与道德麻痹现象。如果假定折现率是10%,那么15年后的100元相当于今天的24元。当下损失24元远不至于引起人们的认知与道德上的愤怒,正是由于对未来风险的习惯性折现,导致我们对于当下风险的不敏感,只要你想想上例中的24元损失,它完全在你的承受范围之内,故而你也就觉得问题不是很严重。人脸识别技术就是这种具有低敏感性的技术,要记得,温柔刀也是可以杀人的。

【备注】本研究得到国家社科基金重大项目“大数据环境下信息价值开发的伦理约束机制研究”的资助,课题编号:17ZDA023,特此致谢!

说明:文中题图来自网络,没有任何商业目的,仅供欣赏,特此致谢。

【博主跋】这篇小文章发在《民主与科学》2019(3),时隔多年,再次投稿,与尚老师合作愉快,这是原稿,是为记。

https://wap.sciencenet.cn/blog-829-1186830.html

上一篇:科学文化是中国可选择的最佳文化变革路径

下一篇:读已死之人的书之150:阿赫玛托娃:《没有英雄的叙事诗》