博文

Transformer用于集成电路AI预测的经验  精选

精选

||

今天上午我群发了我们课题组一份2023年6月15日的网上资料《Transformer全新里程碑,诞生6年,开山之作被引近8万》,网页链接:https://www.ithome.com/0/699/973.htm

其中的一段话“2020年10月,谷歌提出的Vision Transformer (ViT),不用卷积神经网络(CNN),可以直接用Transformer对图像进行分类” 和相应的图片特别引起了我的关注。

因此,我在我们课题组微信群里说了我的一些看法:

“这个工作和我们做的电路布线层的等效性能AI预测的九宫格技术真的是不谋而合啊!世界真的是这样的小!”

注:摘自我的2023年12月7日科学网博文《集成电路产品可靠性建模仿真与智能预测技术的校企交流》(网页链接:https://blog.sciencenet.cn/home.php?mod=space&uid=99553&do=blog&id=1412800 )中的第5、17和18页图片。

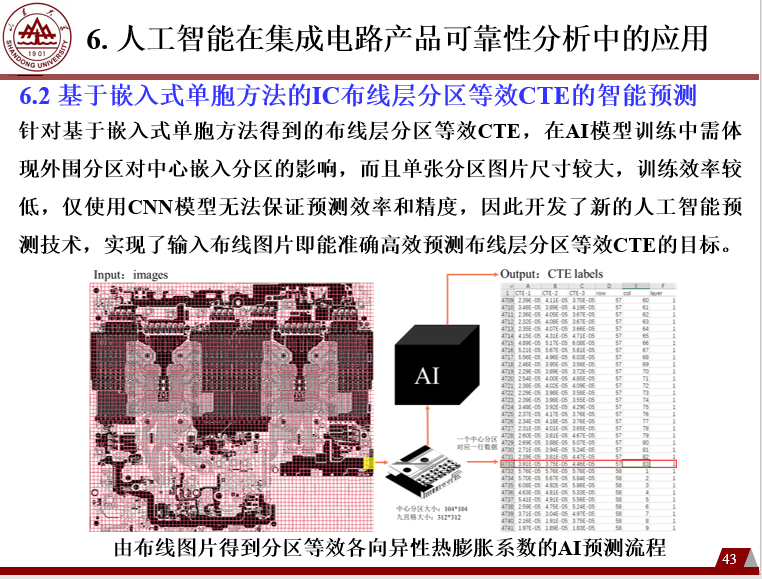

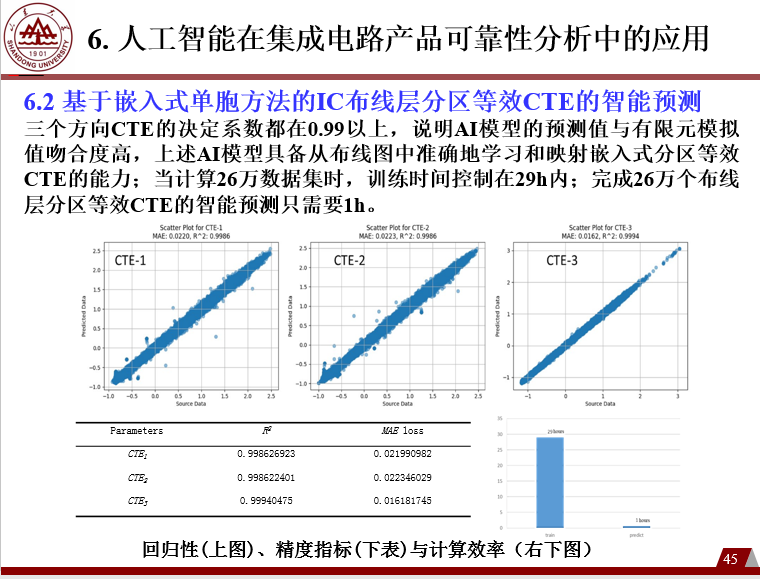

我还进一步谈了自己的看法:“看Transformer的发展史(2017年至今)和其技术特点、应用领域的拓展,给我们很大的启示!回顾我们课题组用Transformer的发展历程和心路:嵌入式单胞模型的建立(九宫格形式的电路布线图像及其几何分区和像素建模)、电路布线层的等效性能的有限元模拟(高精度高效率地得到几万、几十万甚至几百万个电路布线分区的数十个材料性能的数据)、不得不努力实现九宫格形式的电路布线的等效性能AI预测否则就没有工程应用价值,恰是发挥了Transformer的最大特长(输入变量通过Embedding和Positional Encoding实现向量式编码),从而借助Transformer内禀的注意力机制算法,大幅度地降低了算力资源需求,提高了迭代计算效率和收敛性。假如没有Transformer对九宫格形式的电路布线图像的特征工程,而用经典的CNN,我严重怀疑其AI预测精度和效率,甚至就没有工程应用价值。感谢QW同学、ZZY同学、WGS同学等的锐意创新和不懈探索,蹚出了一条生路,为我们开启了全新的发展空间!”

我们课题组的WGS博士生进一步给出了他的最新研究经验和看法:“贾老师中午好,看到您在课题组群里发的有关ViT的事情。前两天修改稿件的时候受到审稿人的启发,前两天将修改稿发给同学们修改以后,我就尝试使用ViT和其它一些CNN+Transformer的方法来预测分区等效材料参数。目前一共跑通了4个模型,包括ViT、Vgg16+Bert、Vgg16+GPT2和一个增加了自注意力的Vgg16。因为目前实验室的所有的4090 GPU服务器都在使用中,我只在笔记本上用小规模数据测试了一下,其中ViT的性能非常优异,不论是训练过程的收敛性还是泛化能力,都非常好,这可能跟Transformer模型能够捕捉全局上下文和长距离依赖关系的优势有关,这对于理解布线图中的复杂关系应该是很适合的。只是还没有用完整样本集训练,对模型的效率等还没有特别明了的认知。这是实现ViT的源代码,还不是很完善,本来打算充分完善以后再跟同学们分享,不过现在应该也能帮助同学们在九宫格方法上的应用”。

看到WGS同学的关于AI+IC的新进展,我也很高兴,特别在我们课题组微信群里说出了自己的意见:“特别感谢WGS同学刚刚分享的ViT源代码和他的使用经验,非常有价值!他还是采用了单胞模型(不涉及九宫格形式的电路布线图像及其内部的几何分区),但是从经典或者说传统的CNN(具体的模型是Vgg16模型)换成了ViT(Vision Transformer)和其它一些CNN+Transformer的方法,继续预测电路布线层的分区等效材料参数,目前看取得了很好的效果(竟然用其笔记本电脑和小规模数据就取得了很好的AI训练效果,这是我们之前完全不敢想象的AI训练效率和效果啊)”。

写在最后的话:和大家分享我们课题组在Transformer模型用于集成电路性能AI预测的初步经验和教训,欢迎大家批评指正,助推AI+IC产业技术进步,更希望对“生成式AI+产业”的技术进步及推广有启发。

https://wap.sciencenet.cn/blog-99553-1423924.html

上一篇:"碰瓷"文生视频Sora的核心技术Diffusion Transformer

下一篇:面向可靠性分析的电路布线层性能智能预测论文